Некоторые страницы сайта содержат одинаковый контент и различаются только get параметрами в url

Ошибка Я. Вебмастера: найдены страницы дубли с GET-параметрами — что делать

Дубли страниц могут приводить к потери позиций в поисковой выдаче и снижать скорость индексации. Стоит понимать, что у поискового робота есть определенный лимит запросов к домену в день. Поэтому существует вероятность того, что он потратит все лимиты на сканирование мусорных страниц и не доберется до страниц с уникальным контентом.

О наличии проблемы с дублированным контентом свидетельствует сообщение в панели Вебмастера: «Найдены страницы дубли с GET параметрами». В своем сообщении Яндекс информирует вебмастера о том, что на некоторых страницах сайта размещен одинаковый контент, различающийся только гет-параметрами.

Что такое get-параметры на сайте

Если в поиске есть дублированные страницы из-за гет-параметров, Яндекс предлагает воспользоваться правилом Clean-param в robots.txt (правило действительно только для Яндекс, Google его не воспринимает).

В результате использования Clean-param поисковый робот Яндекса объединяет сигналы с дублированных страниц на основной. После того, как краулер узнает обо всех произошедших изменениях, страницы с не имеющими значение гет-параметрами исчезнут из поисковой выдачи.

Как использовать Clean-param

Для понимания того, как используется Clean-param, стоит привести простой пример. Существуют дубли страницы со следующими гет-параметрами:

Чтобы в результатах поиска учитывалась только основная страница http://mysite.ru/cat/auto/nissan/, нужно задать правило Clean-param в файле robots.txt:

User-agent: Yandex

Clean-param: sort&order /cat/auto/nissan/

Как использовать Disallow

Избавиться от страниц-дублей с GET-параметрами можно, используя директиву Disallow. Для примера возьмем те же страницы-дубли:

Чтобы в результатах поиска учитывалась только основная страница http://mysite.ru/cat/auto/nissan/, нужно задать правило в файле robots.txt:

User-agent: *

Disallow: *?sort=

Disallow: *&order=

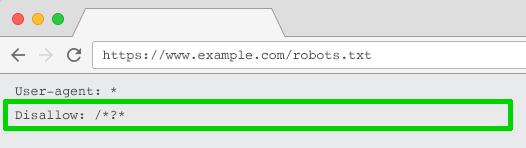

Также можно закрыть от индексации ВСЕ Get-параметры одним правилом?

User-agent: *

Disallow: *?

Будьте осторожны! Используйте директиву Disallow очень внимательно, чтобы случайно не закрыть от индексации нужные страницы (например, не используйте правило, если карточки товара или категории в обязательном порядке содержат get-параметр в url).

Как найти дубли страниц с незначащими GET-параметрами

Дубли страниц на сайте могут появиться в поиске вместо ценных страниц сайта или замедлить их обход и индексирование.

Вообще, дубли — это страницы сайта, содержание текста в которых полностью или практически совпадает. Страницы с GET-параметрами в URL тоже могут быть дублями. Если GET-параметр влияет на содержание страницы — это не дубль. А если GET-параметр не меняет контент страницы, то этот параметр называют незначащим и страницу стоит скрыть от поиска.

Расскажем подробнее, что такое незначащие GET-параметры, как найти дубли с такими параметрами и убрать их.

Что такое дубли страниц с незначащими GET-параметрами

GET-параметр — это параметр, который передается серверу в URL страницы. Он начинается с вопросительного знака. Если URL содержит более одного параметра, то эти параметры разделяются знаком «&». Самый частый случай появления дублей из-за незначащих параметров — метки для задач веб-аналитики. Например, utm_source, utm_medium, from. Такими метками владельцы сайтов привыкли помечать трафик. Фактически эти URL одинаковые, на них опубликован одинаковый контент. Но формально адреса разные, так как различаются GET-параметрами в URL. Соответственно, и поиск тоже может посчитать их разными. Такие страницы и называются дублями с незначащими GET-параметрами.

Наличие дублей страниц с незначащими GET-параметрами не приносит пользы и может негативно сказаться на взаимодействии сайта с поисковой системой.

Зачем отслеживать дубли

1) Скорость обхода. Когда на сайте много дублей, роботы тратят больше времени и ресурсов на их обход, вместо того, чтобы обходить ценный контент. А значит, ценные страницы вашего сайта будут медленнее попадать в поиск.

2) Неуправляемость. Так как поисковой робот произвольно выбирает, какой из дублей показывать в поиске, то на поиск могут попасть не те страницы, которые вам нужны.

3) Влияние на поиск. Если незначащие параметры не добавлены в clean-param, робот может обходить эти страницы и считать их разными, не объединяя их в поиске. Тогда поисковый робот будет получать разные неагрегируемые сигналы по каждой из них. Если бы все сигналы получала одна страница, то она имела бы шансы показываться выше в поиске.

4) Нагрузка на сайт. Лишний обход роботом также дает нагрузку на сайт.

Например, на сайте по продаже билетов есть форма заявки на обратный звонок. При ее заполнении в url передается GET-параметр?form=show1, — он сообщает информацию о том, какой спектакль с этой страницы выбрал пользователь в заявке, хотя контент самой страницы никак не меняется. Таким образом, поисковой робот будет тратить время на обход множества одинаковых страниц, различающихся только GET-параметрами в URL, а до ценных страниц сайта доберется значительно позже.

Для интернет-магазинов типичный пример — страницы с фильтрами. Например, если пользователь выбирает товары в дорогом ценовом диапазоне, изменяя значения в фильтре «Цена», то в большинстве случаев ему будет показана страница с одними и теми же товарами. Таким образом, поиск будет получать сигналы о множестве одинаковых страниц, отличающихся только GET-параметром price= в URL.

Как обнаружить дубли

Теперь находить одинаковые страницы стало проще: в разделе «Диагностика» появилось специальное уведомление, которое расскажет про дубли из-за GET-параметров. Алерт появляется с небольшой задержкой в 2-3 дня, поэтому если вы увидели в нем исправленные страницы, не пугайтесь — это может быть связано с задержкой обработки данных. Дубли с параметром amp, даже если они у вас есть, мы не сможем показать в алерте.

Подписываться на оповещения не нужно, уведомление появится само. Если вы обнаружили дубли:

1. Перейдите в Вебмастер, откройте раздел Страницы в поиске, в таблице выберите Исключенные страницы.

2. Загрузите архив (подходящий формат можно выбрать внизу страницы) и просмотрите скачанный файл: у страниц-дублей будет статус DUPLICATE.

Как оставить в поиске нужную страницу

1. Добавьте в файл robots.txt директиву Clean-param, чтобы робот не учитывал незначащие GET-параметры в URL. Робот Яндекса, используя эту директиву, не будет много раз обходить повторяющийся контент. Значит, эффективность обхода повысится, а нагрузка на сайт снизится.

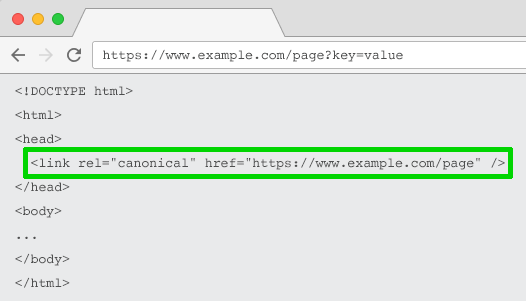

2. Если вы не можете добавить директиву Clean-param, укажите канонический адрес страницы, который будет участвовать в поиске. Это не уменьшит нагрузку на сайт: роботу Яндекса всё равно придётся обойти страницу, чтобы узнать о rel=canonical. Поэтому мы рекомендуем использовать Сlean-param как основной способ.

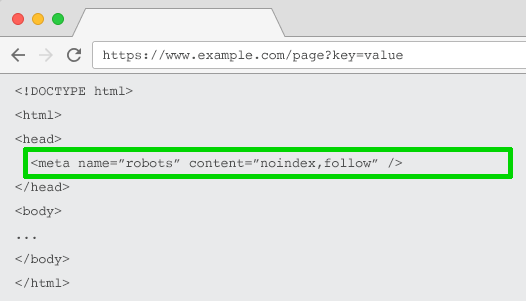

3. Если по каким-то причинам предыдущие пункты вам не подходят, закройте дубли от индексации при помощи директивы Disallow. Но в таком случае поиск Яндекса не будет получать никаких сигналов с запрещенных страниц. Поэтому мы рекомендуем использовать Сlean-param как основной способ.

Найдены страницы-дубли с GET-параметрами

Нет времени читать статью?

Но вам требуется продвижение сайта или создание сайта-лидера, идеального для SEO? Тогда вы можете оставить заявку на продвижение или заявку на создание сайта. Если вы собираетесь продвигать сайт самостоятельно — продолжайте чтение!

У сайта появились дубли страниц, которые мешают ему продвигать и создают проблемы: идет снижение индексации, ранжирования. Каждый день поисковая система индексирует определенный сайт и у него есть свой лимит к домену в сутки. Когда все лимиты уходят на мусорные страницы и URL, становится обидно, потому что качественные страницы с уникальным контентом остались в стороне.

Как узнать есть ли дубли на сайте? Например, в вебмастере Яндекс появилось сообщение: «Найдены страницы дубли с GET параметрами». Это значит, что поисковая система передает информацию владельцам сайтам, что контент есть на разных страница, а он одинаковый везде.

Что такое get-параметры на сайте

GET параметры в URL — специальные динамические параметры, которые позволяют изменять контент на страницах сайта. Часто находится в URL адресе сразу же после «?» и может разделяться «&». Часто владельцы сайтов интернет магазинов используют GET запросы и параметры для фильтров на сайте, либо для сортировки.

Как избавиться от ошибки — Найдены страницы дубли с GET-параметрами

Простой и рабочий способ избавиться сейчас от таких дублей внести правки в ваш файл Robots.txt, через директорию и правила Clean-param или Disallow.

Если вы видите, что у вас появились дубли (дублированные страницы) из-за GET параметров, то Яндекс предлагает сделать вам правило Clean-param, которое будет действовать именно для Яше.

Это позволит поисковому роботу понять и объединить страницы, которые являются дублями. Если произошли изменения, тогда бот сможет их проверить и убрать лишний мусор из поиска.

Как использовать Clean-param

Как правильно использовать Clean-param, ниже будет небольшой пример сайта магазина. Например у нас на сайте есть такие дубли:

Чтобы запретить индексацию этих сортировок и фильтров, нужно добавить в robots.txt следующее:

User-agent: Yandex

Clean-param: sort&order /cat/auto/nissan/

sort&order – это уникальные параметры, которые могут меняться и требуют учета;

/cat/auto/nissan/ — это категория разделах, и те которые начинаются с /cat/auto/nissan/.

Как использовать Disallow

Другой проверенный способ избавиться от дублей с GET-параметрами можно, используя директиву Disallow. Опять же берем те же адреса, что выше в примере.

Задаем правило в файле robots.txt:

Как полностью закрыть все параметры GET одной строкой?

Однако нужно понимать, что если вы полностью закроете все страницы от индексации, иногда есть специальные страницы, которые могут быть обязательны.

Однако способами выше вы сможете решить проблему в Вебмастере Яндексе, гугле.

Ссылки с разными get параметрами это дубли?

Я бы не считал это дублем. Параметр может влиять на формирование результата. Только лишь на основании не особо удачного названия параметра со словом ‘fake’ я бы не стал делать выводов о том как он влияет на результат.

Другими словами, я бы спросил себя : Влияет ли на результат параметр? Если да, то это не дубли

Если ПС добавить оба эти URL в свою базу, и по ним показывается один и тот же контент (а раз параметр фейковый, то и контент будет одинаковый), то да, она посчитает эти страницы дублями.

canonical действительно поможет этого избежать.

Еще есть директивы в robots.txt у Яндекса: https://yandex.ru/support/webmaster/controlling-ro.

но гугл их вроде не поддерживает.

А вообще используйте Sitemap и будет вам счастье

каждый из данных вариантов имеет минусы, так что выбирать нужно под сайт индивидуально

Как избежать SEO-проблем с параметрами URL: подробное руководство

Автор: Джес Шольц (Jes Scholz), digital-директор, Ringier

Хотя веб-разработчики и поклонники аналитики любят параметры, для SEO-специалистов они часто являются кошмаром. Бесконечные комбинации параметров могут создавать из одного и того же контента тысячи вариантов URL.

Проблема в том, что мы не можем их игнорировать. Параметры играют важную роль в пользовательском опыте. Поэтому необходимо понять, как правильно обращаться с ними с точки зрения SEO.

Что такое параметры URL?

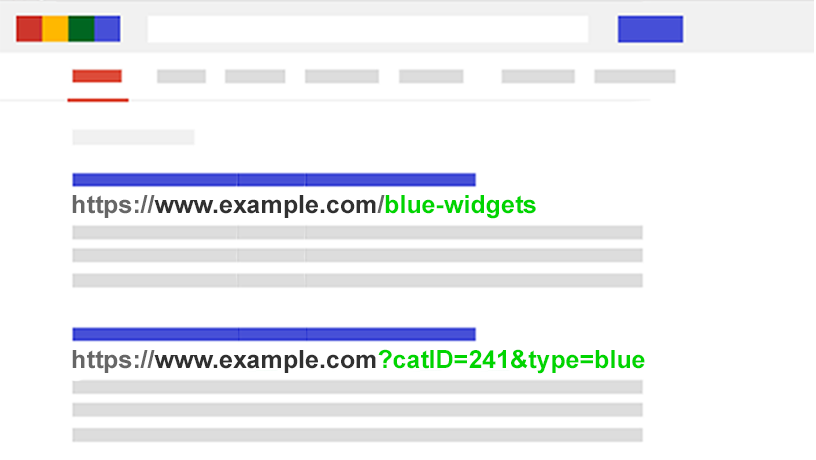

Параметры URL, также известные как строки запроса и переменные URL, представляют собой ту часть URL-адреса, которая идёт после знака вопроса.

Они состоят из пары «ключ + значение», разделённых знаком равенства (=). Используя амперсанд (знак &), можно добавить несколько параметров на одну страницу.

Самые распространённые варианты использования параметров:

SEO-проблемы при использовании параметров URL

1. Параметры создают дублированный контент

Зачастую параметры URL не вносят существенных изменений в содержимое страницы. Переупорядоченная версия страницы часто не сильно отличается от оригинала, а URL страницы с тегами отслеживания или идентификатором сеанса идентичен оригиналу.

Например, следующие URL-адреса все будут возвращать подборку виджетов:

Таким образом, мы получаем несколько URL для, по сути, одного и того же контента. Теперь представьте такую ситуацию для каждой категории на сайте.

Проблема в том, что поисковые системы обрабатывают каждый URL с параметрами как новую страницу. Поэтому они видят несколько вариаций одной и той же страницы. При этом все они содержат дублированный контент и нацелены на одну и ту же ключевую фразу или тему.

Хотя дублирование такого рода вряд ли вызовет полное выпадение сайта из результатов поиска, оно приводит к каннибализации ключевых слов и может ухудшать представление Google об общем качестве сайта, поскольку эти дополнительные URL-адреса не приносят реальной пользы.

2. Параметры расходуют бюджет сканирования

Сканирование страниц с большим количество параметров истощает бюджет сканирования, снижая возможность индексирования важных для SEO страниц и повышая нагрузку на сервер.

Google описал эту проблему в Справке для вебмастеров:

«Слишком сложные URL, особенно включающие несколько параметров, могут затруднять работу поисковых роботов, так как создается чрезмерное количество URL-адресов, указывающих на одно и то же или схожее содержание на сайте. В результате робот Googlebot может использовать гораздо больше ресурсов канала передачи данных, чем это необходимо. Кроме того, есть вероятность, что он не сможет просканировать всё содержание сайта полностью».

3. Параметры распыляют сигналы ранжирования страницы

Если у вас имеется несколько вариантов одного и того же содержимого страницы, то ссылки и репосты в социальных сетях могут поступать для разных его версий.

Это размывает сигналы ранжирования страницы. В такой ситуации краулеру может быть сложно понять, какую версию страницы следует индексировать для поискового запроса.

4. Параметры делают URL менее кликабельными

Давайте посмотрим правде в глаза: параметры малопривлекательны. Их трудно читать. Они не вызывают доверия. Соответственно, такие URL получают меньше кликов. А это может отразиться на эффективности страницы в поиске. Причём, не только потому, что CTR может влиять на ранжирование, но также потому, что такие URL менее кликабельны в социальных медиа, в email-сообщениях, при копировании на форумах и в других местах, где может отображаться полный URL-адрес. Каждый твит, лайк, репост, email, ссылка и упоминание имеют значение для домена.

Плохая читабельность URL приводит к снижению вовлечённости во взаимодействие с брендом.

Оцените масштабы проблемы с параметрами на сайте

SEO-специалисту важно знать о каждом параметре, используемом на его сайте. Однако отнюдь не факт, что разработчики будут обновлять этот список.

Как найти все параметры, используемые на сайте? Или понять, как поисковые системы сканируют и индексируют такие страницы? Узнать, какую ценность они несут для пользователей?

Выполните следующие пять шагов:

Вооружившись этими данными, вы сможете решить, как наилучшим образом обойтись с каждым параметром вашего сайта.

SEO-решения для «укрощения» параметров URL

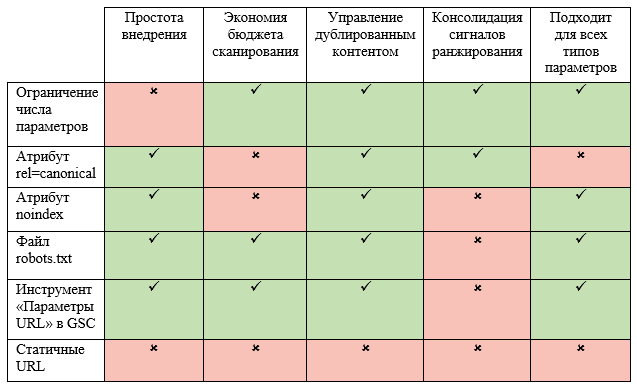

Для работы с параметрами URL на стратегическом уровне в арсенале SEO-специалиста есть 6 инструментов. Рассмотрим их подробнее.

Ограничьте количество URL, основанных на параметрах

Простая проверка того, как и почему генерируются параметры, может обеспечить быстрые выигрыши для SEO. Ниже – четыре частые проблемы, с которых стоит начать работу.

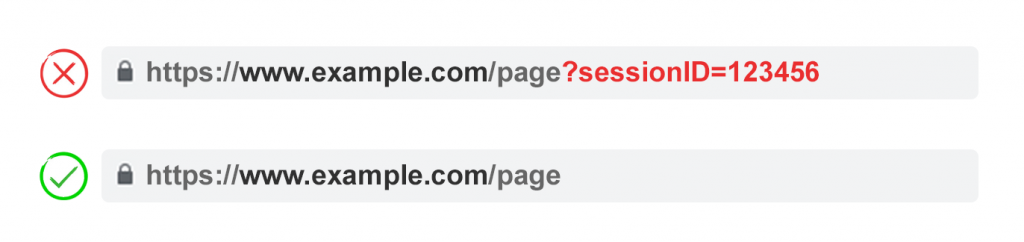

1. Удалите ненужные параметры

Попросите своего программиста предоставить вам список всех параметров и их функций. Есть шансы, что вы обнаружите те параметры, которые больше не выполняют полезной функции. Так, пользователи могут быть лучше идентифицированы с помощью файлов cookies, а не идентификаторов сеансов. При этом параметр sessionID может по-прежнему присутствовать на сайте, поскольку он использовался ранее.

Или же вы можете обнаружить, что фильтр в фасетной навигации редко применяется вашими пользователями.

Любые параметры, вызванные техническими недоработками (незавершёнными изменениями в программном коде) должны быть немедленно устранены.

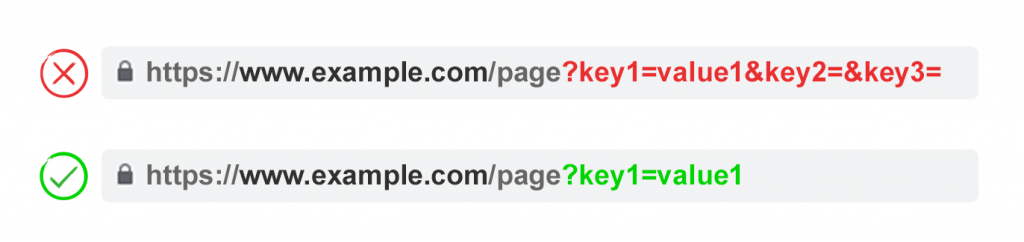

2. Не допускайте появления пустых значений

Параметры должны добавляться к URL только в том случае, когда у них есть полезная функция. Не допускайте добавления ключей параметров, если у них пустое значение.

Так, на примере выше key2 и key3 не добавляют URL никакой ценности.

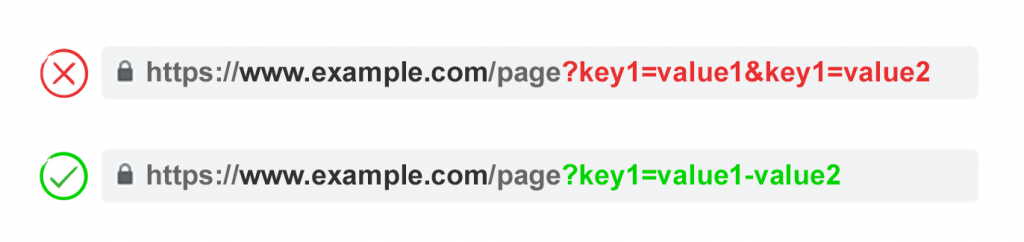

3. Используйте ключи только один раз

Избегайте применения нескольких параметров с одним и тем же именем, но разным значением.

Для множественного выбора лучше объединять значения после ключа.

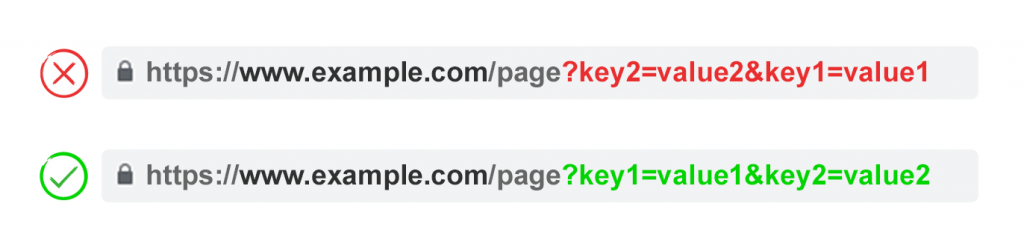

4. Очерёдность параметров

Если одни и те же параметры URL поменяны местами, то страницы интерпретируются поисковыми системами как идентичные. Поэтому порядок параметров не значим с точки зрения дублированного контента. Однако каждая из этих комбинаций сжигает бюджет сканирования и рассеивает сигналы ранжирования.

Во избежание этих проблем, попросите своего разработчика написать скрипт, который будет гарантировать добавление параметров в определённом порядке – независимо от того, как пользователь будет их выбирать.

Мы рекомендуем начинать с параметров языка, затем добавлять идентификацию, пагинацию, фильтрацию или поисковые параметры, а в самом конце – отслеживание.

Плюсы:

Минусы:

Атрибут rel=”canonical”

Атрибут rel=”canonical” указывает, что содержимое страницы идентично или похоже не содержимое другой страницы. Это побуждает поисковые системы объединять сигналы ранжирования по URL, указанному как канонический (основной).

Таким образом, вы можете добавить этот атрибут на URL с параметрами, указав как канонический более оптимизированный с точки зрения SEO URL-адрес – для отслеживания, идентификации или переупорядочивания контента. Однако эта тактика не подойдёт в том случае, когда содержимое страницы с параметрами недостаточно похоже на содержимого канонического URL.

Плюсы:

Минусы:

Директива noindex в метатеге robots

Настройте директиву noindex для любой страницы с параметрами, которая не имеет ценности для SEO. В результате поисковые системы не будут индексировать эти страницы.

Кроме того, такие URL реже сканируются, а директива noindex, follow со временем переходит в noindex, nofollow.

Плюсы:

Минусы:

Директива Disallow в файле robots.txt

Файл robots.txt – это то, на что поисковые системы смотрят в первую очередь, прежде чем сканировать сайт. Если они увидят там запрет на что-либо, то на следующую стадию даже не перейдут.

Вы можете использовать этот файл, чтобы заблокировать краулерам доступ к URL с параметрами с помощью директивы Disallow: /*?* или указания конкретных строк запроса, которые не должны индексироваться.

Плюсы:

Минусы:

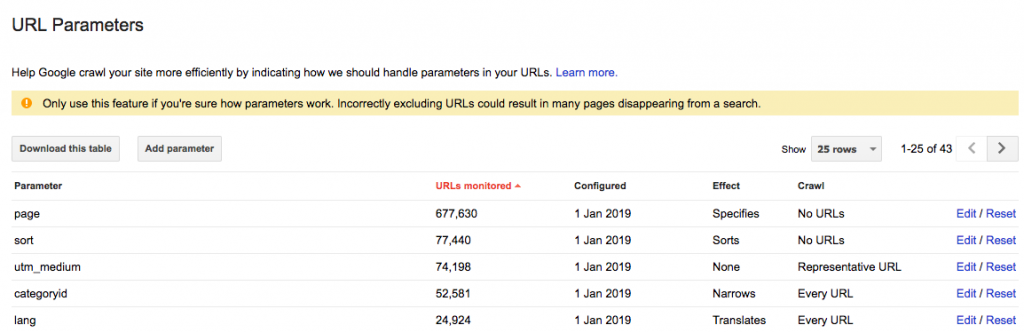

Инструмент «Параметры URL» в Google Search Console

Настройте инструмент «Параметры URL» таким образом, чтобы он сообщал краулерам назначение ваших параметров и то, как бы вы хотели, чтобы они обрабатывались.

Google Search Console предупреждает, что использование этого инструмента «может привести к исчезновению многих страниц из поиска».

Это может звучать зловеще, но что ещё более пугающе, так это тысячи дублированных страниц, которые вредят ранжированию вашего сайта.

Поэтому лучше узнать, как настроить параметры URL в Search Console, чем позволить решать Googlebot.

Ключ в том, чтобы спросить себя, как каждый параметр влияет на содержимое страницы.

При выборе варианта «На усмотрение робота Googlebot» Google автоматически добавит параметры в список. Проблема в том, что удалить эти параметры не получится – даже если они больше не нужны. Поэтому, когда это возможно, лучше заранее добавить параметры самостоятельно. Тогда, если параметр перестанет использоваться, вы сможете удалить его из Search Console.

Плюсы:

Минусы:

Перейдите от динамических URL к статическим

Многие считают, что оптимальный способ обхождения с параметрами URL – это просто избегать их. В конце концов, подпапки лучше, чем параметры, помогают Google понять структуру сайта, а статические URL-адреса на основе ключевых слов всегда были краеугольным камнем on-page SEO.

Чтобы достичь этой цели, вы можете использовать перезапись URL-адресов на стороне сервера для преобразования параметров в URL-адреса подпапок.

Например, текущий URL:

Однако его использование становится проблематичным для некоторых элементов фасетной навигации, таких как цена. Наличие такого фильтра в качестве статического индексируемого URL не несёт никакой ценности для SEO.

Это также проблема для поисковых параметров, поскольку каждый сгенерированный пользователем запрос будет создавать статичную страницу, которая будет соперничать за ранжирование с канонической. Или, что ещё хуже, будет предоставлять краулерам страницы с низкокачественным контентом всякий раз, когда пользователь будет искать товар, которого нет на сайте.

Этот подход также не очень применим к пагинации (хотя это не редкость из-за WordPress), поскольку в итоге он даст примерно такой URL:

Ещё более странно будет выглядеть URL при переупорядочивании контента:

Кроме того, зачастую это неподходящий вариант для отслеживания. Google Analytics не признаёт статическую версию UTM.

Более того, замена динамических параметров на статические URL для таких вещей, как пагинация, поиск на сайте или сортировка, не решает проблему дублированного контента, расхода краулингового бюджета или рассеивания ссылочного веса.

При этом наличие всех комбинаций фильтров из фасетной навигации в качестве индексируемых URL часто приводит к проблемам с так называемым «thin» контентом. Особенно в том случае, если вы предлагаете фильтры с множественным выбором.

Многие SEO-специалисты утверждают, что можно обеспечить такой же пользовательский опыт, не затрагивая URL. Например, используя POST-запросы вместо GET-запросов для изменения содержимого страницы, что позволяет сохранить пользовательский опыт и избежать проблем с SEO.

Однако удаление параметров таким способом лишит вашу аудиторию возможности добавить страницу в закладки или поделиться ссылкой на неё. И этот вариант явно не подходит для параметров отслеживания и не является оптимальным для разбивки на страницы.

Суть в том, что для многих сайтов этот подход не приемлем, если нужно обеспечить идеальный пользовательский опыт. Это также не является лучшей практикой с точки зрения SEO.

Таким образом, те параметры, которые не должны индексироваться (пагинация, переупорядочивание, отслеживание и т.п.), реализуйте как строки запроса. А для тех параметров, которые должны индексироваться, используйте статические URL.

Плюсы:

Минусы:

Какой подход выбрать?

Итак, какой же из этих шести подходов следует внедрить? Выбрать все сразу нельзя. Это создаст ненужные сложности. Кроме того, разные SEO-решения нередко конфликтуют друг с другом.

Например, если вы настраиваете директиву disallow в файле robots.txt, то Google не должен видеть метатеги noindex. Кроме того, метатег noindex не следует сочетать с атрибутом rel=canonical.

Ясно одно: идеального решения нет.

Даже сотрудник Google Джон Мюллер не может определиться с подходом. Во время одной из видеовстреч для вебмастеров он сначала посоветовал не запрещать параметры, но когда его спросили об этом с точки зрения фасетной навигации, он ответил: «Здесь возможны варианты».

Есть случаи, когда эффективность сканирования более важна, чем консолидация сигналов авторитетности. В конечном счёте, оптимальное решение будет зависеть от ваших приоритетов.

Лично я не использую noindex и не блокирую доступ к страницам с параметрами. Если Google не может сканировать и понимать все переменные URL, то он не может объединить сигналы ранжирования на канонической странице.

Оптимальное управление параметрами для SEO

Мы рекомендуем придерживаться следующего плана:

Какую бы стратегию вы не выбрали, обязательно документируйте влияние своих действий на KPI.