За что отвечает герцовка

Нужны ли геймеру мониторы на 100+ герц и FPS > 30?

Игровые мониторы уже давно преодолели планку в 100 Гц. И все же это маркетинг или прорывная технология? Пытаемся разобраться.

Современные процессоры покоряют новые вершины тактовой частоты и разрастаются в количестве ядер и потоков. Жесткие диски с каждым годом уверенно прибавляют в объемах. Проводные интерфейсы улучшают показатели пропускной способности.

А что на счет мониторов? Разработчики создают новые технологии, призванные улучшить качество картинки. Однако это не единственное направление эволюции экранов. Новые премиальные модели имеют очень высокую частоту опроса и этот показатель регулярно улучшается. Но что это такое? Как это связано с производительностью видеокарты? Что такое кадры в секунду? И стоит ли обращать внимание на высокогерцовые мониторы? Обо всём этом сегодня и поговорим.

Герцы в мониторах: что это такое?

Герцовка монитора — это значение, показывающее, как часто обновляется изображение. Измеряется оно в герцах. Подавляющее большинство современных мониторов имеет частоту обновления 60 Гц. Однако этот показатель напрямую зависит от производительности видеокарты. Скорость обработки видеокартой измеряется в кадрах в секунду (FPS, framerate). Для того чтобы лучше понимать, как все это работает, давайте разберем на примере.

Предположим ваша видеокарта в какой-то игре выдает 80 кадров в секунду. Это значит, что при текущей нагрузке, изображение в игре будет меняться со скоростью в 80 FPS. Но это просто выработка железа. Отображением картинки занимается монитор. Предположим, что частота опроса вашей матрицы составляет 60 Гц. В таком случае, он не сможет отобразить большее количество кадров, чем его герцовка. Получается, что бесполезно иметь мощное железо и бюджетный монитор?

С одной стороны, это действительно так. Пусть у вас будет хоть 1000 FPS, на 60-герцовом мониторе вы увидеть лишь 60 кадров из этой тысячи. Но все мы прекрасно понимаем, что нагрузка в играх не является статичной и во время особо динамичных сцен, фреймрейт может ощутимо просесть. Получается, что всё же необходимо иметь небольшой запас избыточных кадров.

Высокочастотные матрицы

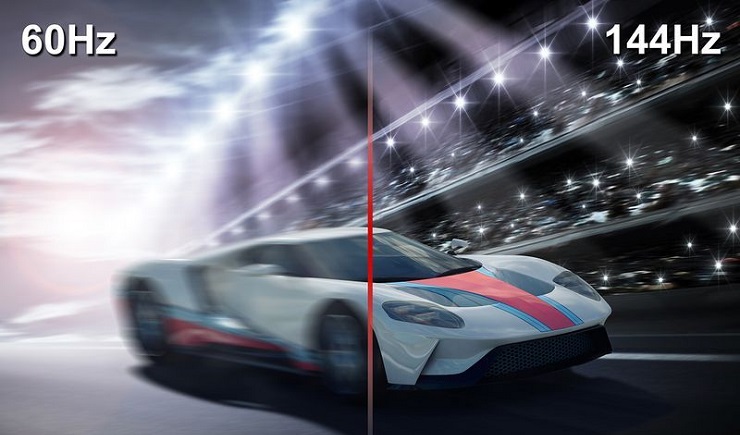

А что на счет мониторов с высокой частотой опроса (от 100 Гц), нужны ли они? В основном такие пригодятся геймерам, потому что игровой процесс становится намного более плавным, и чем больше фреймов способен отобразить монитор, тем «мягче» будет меняться игровое окружение. Однако стоит понимать, что под такие мониторы требуется мощная видеокарта, выработка которой будет 144+ FPS. Если она будет вырабатывать лишь 100 кадров, то даже на 144-герцовом мониторе вы увидите лишь эти 100 кадров, ни больше, ни меньше.

Но ведь, у всего есть свой предел, верно? Сколько кадров сможет «распознать» человеческий глаз? Какой показатель герцовки является оптимальным для среднестатистического пользователя? Ответить на этот вопрос довольно трудно, поскольку всё зависит от индивидуальных особенной каждого человека. Всё мы разные. Чья-то скорость реакции составляет 0,2 секунды, чья-то — более секунды. Кто-то хорошо видит в темноте, кто-то плохо. Кто-то слышит высокочастотные звуки, а кто-то нет.

Нельзя определенно точно сказать, что именно вы заметите разницу между 60 и 144 герцами. Но, как показывают исследования, человеческий глаз способен распознавать не одну сотню кадров в секунду, если вообще можно так выразиться. Мы думаем, что стоит в любом случае попробовать. Лично мы уже никогда не вернемся на 60-герцовые экраны.

Что такое герцы в мониторе

Все модели мониторов имеют основные характеристики — разрешение, оклик и частота обновления.

Что такое герцы в мониторе

Если говорить простыми словами, частота обновления — это числовая величина, показывающая сколько раз в секунду изображение на экране будет обновлено.

СПРАВКА! Если экран имеет характеристику, равную 60 Гц, это значит, что именно столько раз картинка будет обновлена за одну секунду времени.

Чем выше это значение, тем чаще будет обновляться картинка, и как следствие, изображение будет более плавным и чётким.

От чего зависит герцовка монитора?

Совсем недавно считалось, что человеческий глаз не способен обрабатывать более 25 кадров в секунду. Однако, сейчас уже доказано, что максимального предела этого значения не существует.

СПРАВКА! Именно из этих двух параметров будет складываться плавность и чёткость передаваемого изображения.

Например, монитор имеет герцовку 60 Гц, а видеокарта способна выдавать гораздо большее значение. В таком случае дисплей просто не будет успевать обрабатывать передаваемое изображение и на картинке будут появляться так называемые «артефакты».

Чтобы картинка была плавной величины FPS и частота обновления должны совпадать.

Правда, мифы и особенности игровых мониторов — часть №1

В последние несколько лет явно прослеживается тренд на игровые комплектующие, и если с процессорами и видеокартами все вполне понятно, то игровые корпуса и игровые вентиляторы вызывают много вопросов. И, разумеется, стали появляться и игровые мониторы, причем массово: так, на CES 2020 было представлено около десятка моделей. Отношение к ним, в общем и целом, достаточно скептическое — дескать, обычных решений с FHD и 60 Гц полностью хватает, зачем эти навороты? Давайте разбираться, так ли это.

Раз глаз не видит больше 24 кадров, то зачем 144 Гц мониторы?

Когда речь заходит про герцовку монитора, то тут всплывают множество мифов. Самый популярный заключается в том, что раз фильмы показывают в 24 кадра в секунду, то, значит, нашему глазу этого достаточно, чтобы видеть не слайдшоу, а плавную картинку — а, значит, все эти 120 и даже 240 Гц мониторы — баловство. Однако тут важно понимать, что кадр из фильма и кадр, который видеокарта выводит на экран, сильно различаются. Кадр в фильме снимался с некоторой выдержкой, то есть он в любом случае слегка смазан и показывает движение, иными словами — внутри каждого кадра из фильма есть информация о предыдущем. Поэтому мозгу хватает всего 24 таких кадров секунду, что бы «слепить» из них плавное видео.

А вот кадр, который выводит на экран видеокарта, всегда четкий (разумеется, если мы не говорим о программном размытии в движении — motion blur), поэтому 24 таких кадра распознаются нашим мозгом как слайдшоу. Но сколько тогда нужно «компьютерных» кадров для плавности? А вот тут уже все индивидуально: в большинстве своем игроки на консолях вполне довольны 30 fps. Но на деле практически все люди замечают разницу между 30 и 60 Гц, а порог распознаваемости отдельных кадров лежит далеко за сотню — как показала презентация Nvidia на CES 2020, хватает людей, которые видят разницу между 240 и 360 Гц мониторами!

Но, разумеется, не стоит сразу бросаться покупать 240 Гц монитор. Проблема в том, что все его прелести вы сможете увидеть только в том случае, если контент будет выводиться со схожей частотой кадров. Иными словами, видео в 60 fps на YouTube будет выглядеть одинаково что на 60 Гц мониторе, что на 120 Гц, и даже на 360 Гц. В общем и целом, единственный контент, в котором вы можете увидеть под две сотни и больше кадров в секунду — это некоторые киберспортивные игры, и то для этого обычно потребуются быстрые процессоры и видеокарты.

В общем и целом, если вы не киберспортсмен, имеет смысл ограничиться 100-144 Гц мониторами. Выдать около сотни кадров в секунду в современных и не очень играх могут уже куда больше видеокарт, а разница с 60 Гц матрицами будет видна невооруженным глазом.

Время отклика монитора — не менее важный параметр, чем частота обновления

Думаю, многие замечали, что если быстро передвигать какое-либо окно по экрану, то за ним тянутся шлейфы. Это происходит из-за того, что пиксели в жидкокристаллических мониторах не могут изменять цвет моментально, им на это нужно определенное время — так называемая задержка матрицы или время отклика монитора.

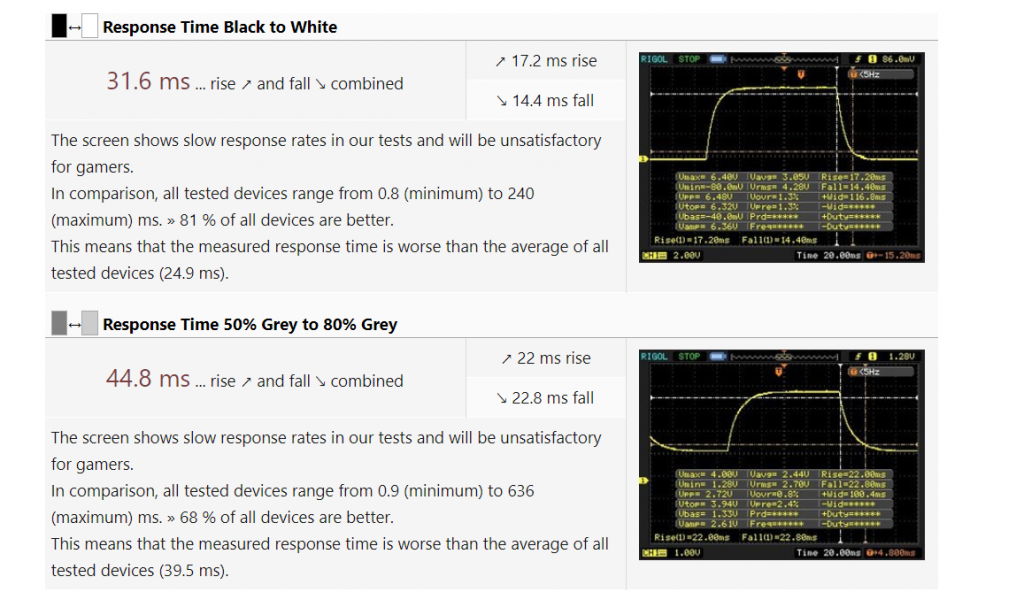

Считать ее можно разными способами, в основном используют показатель grey-to-grey, или GtG: время, которое требуется пикселям, чтобы снизить яркость серого цвета с 80-90% до 10-50% (увы — каждый производитель тут использует свою методику). Данный показатель оказывается наиболее интересным, так как близок к реальному применению: очень редко в играх картинка резко сменяется с белой на черную (BtW, black-to-white), а вот смена яркости цветов происходит постоянно.

Типичная 60 Гц панель в достаточно дорогом ноутбуке с Core i5 и GTX 1660. Играть за ней в динамические игры будет не слишком приятно.

У обычных 60 Гц матриц такой показатель в среднем на уровне 30-50 мс. Много это или мало? Давайте посчитаем. В случае с 60 Гц монитором один кадр отображается на экране 1000 мс/60 = 17 мс. То есть время отклика соответствует отображению двух, а то и трех кадров на экране. К чему это приводит? Да ни к чему хорошему: в динамических играх матрица просто не будет успевать обновлять информацию на экране, что приведет к замыливанию картинки и шлейфам, а в худшем случае в этом цветовом месиве вы просто проглядите врага. В случае со 144 Гц мониторами все еще хуже: на каждый кадр отводится всего 7 мс.

Поэтому, выбирая игровой монитор, стоит внимательно отнестись к его времени отклика, причем не стоит смотреть на рекламные цифры в виде 1-3 мс: производители мониторов измеряют задержку различными хитрыми способами, и на деле по обзорам GtG может у таких матриц быть и 5, и 10 мс. Крайне желательно, чтобы время отображения кадра было больше времени задержки матрицы — это позволит свести шлейфы в динамических играх к минимуму.

Overdrive — разгон матрицы

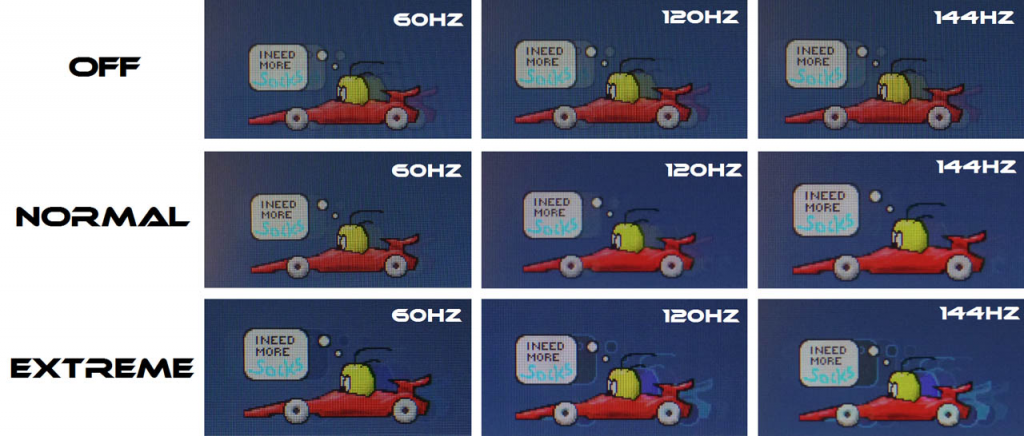

Вот мы и перешли к чисто игровым функциям. Как я писал выше, большое время отклика = смаз картинки, поэтому производители придумали технологию компенсации времени отклика, которую назвали Overdrive. В чем ее суть? Обычно переход от черного цвета к белому для LCD-матриц происходит быстрее, чем между двумя градациями серого. Причина в том, что скорость изменения состояния пикселя зависит от приложенного к нему напряжения, а переход в «белое» состояние — это подача максимального напряжения, поэтому BtW быстрее GtG (что, к слову, и используют маркетологи при указании времени отклика матриц).

Отсюда возникает простая идея: а что если в начале каждого нового кадра подавать на пиксель высокие «разгонные» импульсы напряжения, которые значительно выше тех, которые нужны для реального нового значения цвета? Это даст «толчок» пикселю и позволит ему быстрее перейти в новое положение, существенно снизив задержку матрицы. Однако ложка дегтя в том, что такое резкое повышение напряжения не может пройти бесследно: нет, пиксели от этого не выгорают, просто могут появиться различные артефакты изображения типа светлого мерцания на серых фонах в динамических играх.

Хорошо видно, что при включенном Overdrive в режиме Normal меньше всего артефактов изображения. При этом включение этой функции на Extreme начинает инвертировать цвета, что еще менее приятно, чем выключение этой опции.

По этой причине производитель монитора обычно делает несколько настроек Overdrive, в том числе и возможность полностью его выключить. И уже для конкретного монитора нужно смотреть, что лучше — опять же, об этом пишут в развернутых обзорах.

Высокая частота + низкое время отклика = приятный геймплей

Теперь сложим все воедино и посчитаем общую задержку, которую мы получаем в играх. Она складывается из времени, которое нужно процессору и видеокарте, чтобы обработать ваше нажатие и передать картинку на дисплей. Оно составляет около 50 мс и его вполне можно считать константой. Далее в дело вступает монитор: у нас есть задержка при выводе нового кадра + время отклика.

Посчитаем этот показатель для «стандартной» 60 Гц панели со временем отклика в 40 мс. Худшее время задержки при выводе нового кадра — это если только что на экран вывелся кадр, и теперь нужно ждать 1000 мс/60 = 17 мс, чтобы вывести новый (это на деле не совсем так, но мы рассматриваем наихудший случай). Далее — время отклика, еще 40 мс. В итоге общая задержка получается 50 + 17 + 40 = 107 мс.

Теперь возьмем «игровую» 144 гц матрицу с задержкой GtG в 7 мс (это опять же достаточно много для современных матриц, но мы берем худший случай). Задержка при выводе нового кадра — 1000 мс/144 = 7 мс. Еще 7 мс время отклика. В итоге получаем общую задержку в 50 + 7 + 7 = 64 мс.

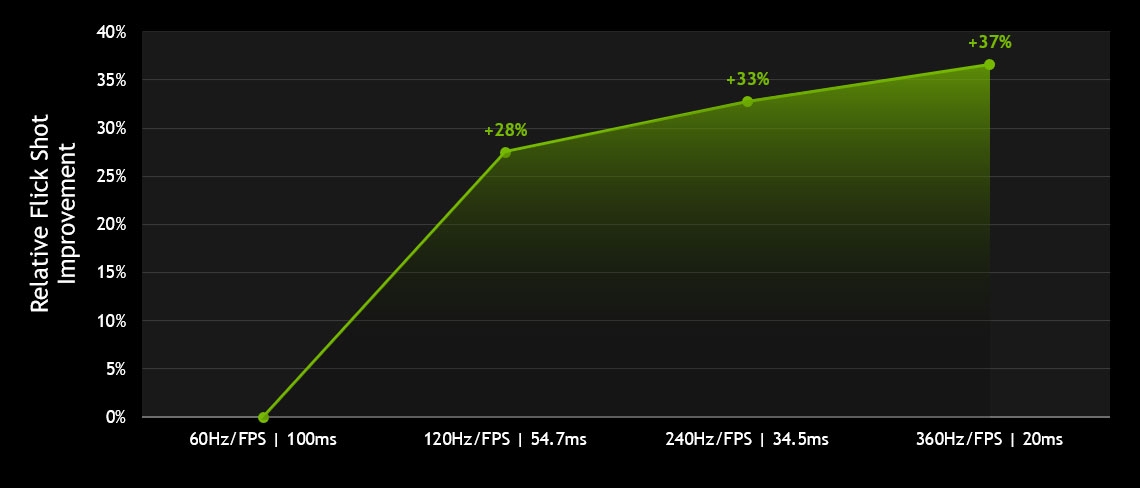

Сложно сказать, как Nvidia считала задержку, однако статистика по флик-шотам (быстрым выстрелам с разворота) вполне красноречива: чем быстрее матрица, тем их больше. Причем основной прирост идет при переходе с 60 Гц на 120, что еще раз говорит о том, что переплачивать за более быстрые панели стоит только киберспортсменам.

В итоге выигрыш в задержке более полутора раз. И это главная причина того, что на быстрых матрицах вам проще играть и попадать во врагов. Так что, как видите, игровые мониторы действительно могут так называться, и это не маркетинг.

AMD FreeSync и Nvidia G-Sync — убираем разрывы в изображении

Большая часть мониторов имеют фиксированную герцовку, однако в динамическом контенте, таком как игры, количество кадров в секунду постоянно меняется. К чему это приводит? Опять же ни к чему хорошему: изображение выводится на дисплей даже в том случае, если вывод части предыдущего кадра ещё не закончен полностью — оставшаяся часть буфера приходится на текущее обновление экрана. Именно поэтому каждый выведенный на монитор кадр при несовпадении частоты и fps будет по сути состоять из двух кадров, отрендеренных видеокартой.

Выглядит это как разрыв изображения, что очень некрасиво:

Как можно в этим бороться? Ну, самый простой способ — это включить вертикальную синхронизацию, то есть принудительно выводить на экран столько кадров, сколько в нем герц. В случае, если видеокарта может выдать большее количество fps, она будет простаивать, а вы получите приятную нерваную картинку. Ну а если монитор 60 Гц, а видеокарта может выдать всего 30-40 fps? В таком случае некоторые кадры будут отображаться на экране вдвое дольше, чем должны, то есть задержка вывода будет скакать между 17 и 34 мс. Разумеется, это будет ощущаться на деле как «вязкое» управление, и играть так будет неприятно.

Какой выход из данной ситуации? Принудительно синхронизировать частоту обновления монитора с количеством кадров, выводимых видеокартой. Иными словами, монитор будет подстраиваться под видеокарту и выводить кадр столько времени, сколько нужно видеокарте на рендеринг следующего, который он снова выведет без всяких задержек. Как итог — вы получаете по сути вертикальную синхронизацию при любом fps. Ну, почти любом.

На данный момент существуют две технологии, которые позволяют убрать разрывы при выводе динамического контента — это AMD FreeSync и Nvidia G-Sync. Разница между ними в том, что первая технология использует для синхронизации частоты развертки и fps видеокарту, а данные об этом передаются по DisplayPort. Вторая технология требует в мониторе наличия специального чипа, который пропускает через себя видеопоток с видеокарты и «подгоняет» под него частоту обновления монитора. Очевидно, что второй подход дороже, причем временами значительно: переплата за чип от Nvidia доходит до 10-20 тысяч рублей.

Что же лучше? Еще год назад я бы сказал, что этот вопрос не корректен: видеокарты от AMD умеют работать только с FreeSync, а видеокарты от Nvidia умели тогда работать только с G-Sync. Однако с учетом того, что видеокарты GTX 1000 и RTX 2000 используют видеоинтерфейс DisplayPort 1.2, дабы соответствовать требованиям VESA компании Nvidia пришлось некоторое время назад добавить в вышеуказанные видеокарты поддержку FreeSync под видом G-Sync Compatible.

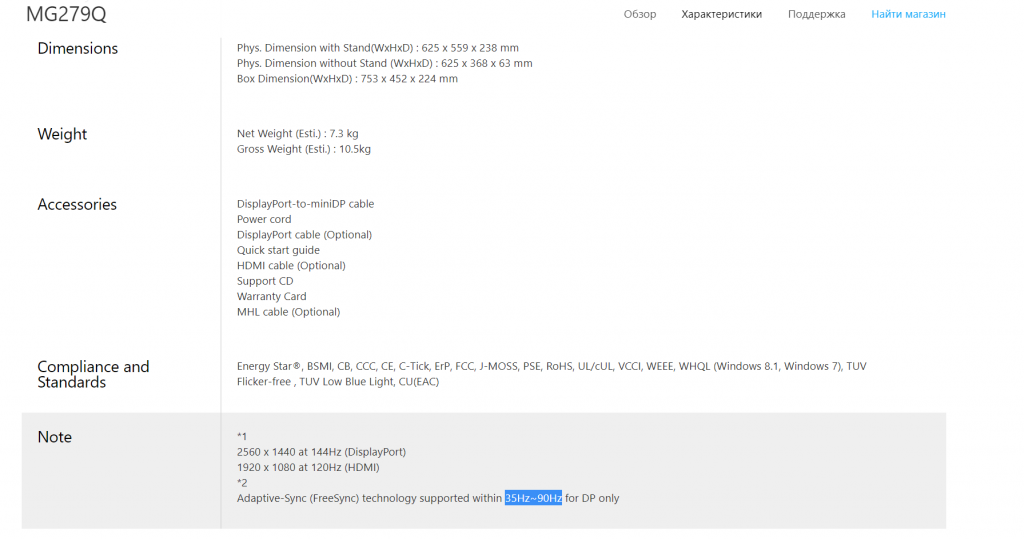

Выходит, что переплачивать за G-Sync теперь нет смысла? Опять же не совсем так. В теории, FreeSync может работать на частотах обновления монитора от 9 до 240 Гц, чего более чем достаточно для подавляющего большинства мониторов и игр. Но что мы видим на практике? Многие даже достаточно дорогие мониторы с ценником выше 1000 долларов поддерживают адаптивную герцовку лишь в узком диапазоне 48-90 Гц (весь список мониторов есть тут). И это при том, что сами они могут быть и 144 Гц! То есть получается, что или вы теряете преимущества быстрой матрицы и играете с

60 fps, или же вы забываете про FreeSync и играете со 100+ fps, но терпите разрывы изображения.

144 Гц, IPS, разрешение 2К — и поддержка FreeSync мелким текстом внизу: от 35 до 90 Гц. Смысл в ней в таком диапазоне не совсем понятен.

Разумеется, есть и такие мониторы, которые поддерживают FreeSync в диапазоне от 48 до 240 Гц, но их очень немного. При этом у мониторов с G-Sync такой проблемы нет: все они гарантированно поддерживают адаптивную герцовку в диапазонах от 30 Гц до родной частоты обновления матрицы. Согласитесь, это куда приятнее и охватывает весь диапазон «играбельного» fps.

В итоге ситуация получается следующей: для пользователей видеокарт от AMD выбора нет, не хотите видеть разрывы — берите монитор с FreeSync, хотите при этом высокую герцовку — придется поискать подходящее решение, которое зачастую может быть дороже видеокарты. Для пользователей видеокарт от Nvidia ситуация интереснее: если хотите плавную картинку без разрывов при любом нормальном fps — имеет смысл переплатить за монитор с G-Sync. Но если есть желание сэкономить — можете окунуться в мир FreeSync мониторов, которых на данный момент около 1000 штук. Драйвером поддерживаются они все, так что выбор по герцовке остается только за вами.

Во второй и заключительной части статьи мы поговорим про остальные «фишки» игровых мониторов, такие как многозонная подсветка, вставка черного кадра и некоторые другие.

Можно ли разогнать монитор и как это сделать

Содержание

Содержание

Игровой монитор стал привычной необходимостью в современных сборках не только для киберспортсменов, но и домашних геймеров. Для комфортной игры теперь есть все: матрицы с низким откликом, режимы для улучшения картинки в шутерах, виртуальные прицелы и другие вспомогательные функции. Но самое интересное в игровом мониторе — это частота развертки. Как правило, самые распространенные модели уже работают на 144 Гц с завода. Но не всегда есть возможность поменять монитор, а улучшить плавность картинки хочется. Тогда можно попробовать его разогнать.

Игровые мониторы появились недавно. Всего несколько лет назад их делили на бюджетные и дорогие, а теперь появилось новое направление — игровые мониторы с высокой частотой обновления. И, чтобы понять, что такое быстрый монитор, не обязательно покупать новый. Можно разогнать старый и наслаждаться привычной картинкой в новом ракурсе.

Частота развертки

Частота монитора — это скорость обновления изображения на мониторе. Если проще: сколько кадров показывает дисплей за секунду — это и будет скорость в герцах. Например, универсальные 60 Гц для среднего монитора. Или 144 Гц для игрового. Или 240 Гц для экстремальной модели. Это все максимальное количество картинок в секунду.

Допустим, у нас есть 10 секунд, чтобы увидеть вспышку праздничного салюта. Теперь представим, что взглянуть на салют можно только несколько раз, остальное время глаза должны быть закрытыми. Открыли — посмотрели — закрыли. И так, допустим, 60 раз за 10 секунд. Сложно. Нужна практика. Но, в итоге, моргая 60 раз, мы увидим достаточно, чтобы сказать «да, это салют, разноцветный и яркий». А теперь снижаем скорость до трех морганий. Так вообще ничего не разглядишь.

Чем чаще мы открываем глаза в каком-то промежутке времени, тем больше информации успеваем заметить. Радует, что человеческий глаз может видеть картинку непрерывно, что не дано электронным устройствам. Тем не менее, есть и другая сторона вопроса о высокой частоте обновления. Очень часто возникают споры о том, сколько кадров достаточно человеку, чтобы картинка казалась плавной и непрерывной. Когда братья Люмьер изобрели кино, все думали, что для этого достаточно показать 24 кадра в секунду.

Однако, как только человек увидел анимацию с 30 и более кадрами в секунду, понимание плавности и непрерывности изменилось. Теперь минимальный комфортный фпс — это 30 кадров в секунду. Дальше — больше. Если 30 кадров достаточно для телевизора и YouTube, то в играх появился свой стандарт — заветные 60 кадров, поэтому совершенству нет предела. Ведь, если верить ученым, человек способен различать качество до 1000 Гц и выше. Отсюда и гонка за герцами.

Так, между 30 и 60 кадрами разница колоссальна. Вот наглядный пример:

Если замедлить видео, то можно понять разницу между 60 Гц и 144 Гц. Как в этом видео:

Тем не менее, высокая частота обновления не только улучшает плавность движений. Есть еще кое-что интересное. Но сначала разгоним матрицу.

Специфика разгона

Мониторы, как и процессоры, видеокарты и оперативную память, можно разгонять по частоте. Они также бывают удачными и нет, поэтому итоговая частота зависит от качества монитора и его комплектующих: матрицы, контроллера, видеовыходов и даже сигнального провода.

Матрицы современных мониторов делятся на TN, IPS и VA. До недавнего времени высокоскоростные мониторы чаще работали на TN, но сейчас на рынке доминируют модели с IPS и VA. Этот переход обусловлен тем, что у новых матриц выше контрастность и цветовой охват. И разгонные способности последних моделей уже не отличаются от матриц TN, у которых раньше было преимущество.

Разъемы

Перед разгоном нужно убедиться, что монитор поддерживает актуальные видеовыходы, которые не будут ограничивать частоту. С этой информацией можно ознакомиться на официальном сайте дисплея. Все версии HDMI и их максимальные возможности можно найти в таблице:

Так, для разгона монитора с разрешением 1920×1080 версия HDMI должна быть как минимум 1.2/1.2a. Или DisplayPort, если такой имеется.

Пределы разгона

Некоторые модели способны поднять частоту с заводских 60 Гц всего до 65 Гц. Скорее всего, такой монитор уже с завода работает в разгоне. Другие модели легко берут 75 Гц, а есть и такие, которые могут работать на 120 Гц. Эти пределы меняются в зависимости от категории, в которой находится дисплей. Если у монитора есть старшая модель с высокой частотой обновления, то младшая модель, возможно, тоже сможет работать шустрее. В любом случае, частота может быть уникальной даже для двух одинаковых моделей.

Разгон

Софт для настройки

Для разгона необходимо иметь кабель подходящей версии HDMI или DisplayPort, а также установленные видеодрайверы. С версией портов и проводов можно разобраться в таблице выше, а драйверы на видеокарту находятся на официальных сайтах производителей — Nvidia и AMD Radeon.

Из программного обеспечения для настройки частоты будет достаточно только стандартных утилит, которые устанавливают вместе с драйвером видеокарты.

Для Nvidia это Панель управления Nvidia:

Для Radeon это Control Center:

Разгоняем

Пример разгона монитора будет выполнен на системе с видеокартой Nvidia, поэтому для подстройки частоты используем фирменную утилиту зеленых. Открываем программу и отправляемся в настройки разрешения:

Попадаем в меню создания пользовательских разрешений, включаем «Режимы, не предлагаемые дисплеем» и щелкаем по кнопке «Создать пользовательское разрешение»:

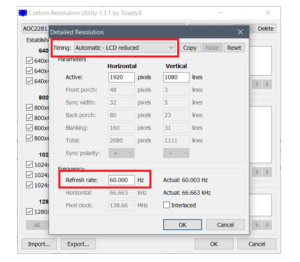

Откроется окно с подробными настройками. Необходимо перейти в окошко выбора частоты обновления и прибавить к стандартному значению 5 Гц, а затем нажать «Тест»:

Если монитор поддерживает работу на этой частоте, изображение на экране на несколько секунд пропадет, а затем снова появится с сообщением о том, что настройки необходимо сохранить.

Можно не сохранять, а продолжить добавлять частоту аналогичным способом. Или вернуть последнее стабильное значение, если после увеличения частоты изображение не появляется или монитор показывает предупреждение о неподдерживаемых режимах:

После того, как максимальная рабочая частота найдена, необходимо сохранить и применить настройки:

А затем вернуться в настройки разрешения в панели управления и применить новое пользовательское разрешение:

Проверка стабильности разгона

Разгон — это выход характеристик за пределы заводских возможностей. Поэтому при изменении частоты техника может работать нестабильно. Чтобы убедиться в том, что настройки частоты подобраны правильно, необходимо проверить их на стабильность.

Сайт позволяет быстро оценить разницу между разным количеством кадров в анимации, а также скажет, если заданная частота нестабильна или создает пропуски.

Допустим, частота монитора равна 60 Гц. Соответственно, чтобы зеленый инопланетянин двигался плавно и без рывков, сайт подбирает частоту кадров равную частоте обновления монитора. Так для 60 Гц:

Так при разгоне до 75 Гц:

Наблюдая за НЛО, мы должны убедиться, что анимация плавная, без рывков и не размывается. Для этого необходимо посмотреть, как монитор ведет себя в этом тесте на заводской частоте, а затем в разгоне.

Если частота стабильна, система покажет зеленый свет:

Проверка «на глаз»

То, о чем говорили в начале материала. Частота монитора влияет как минимум на два визуальных эффекта: плавность и четкость. С плавностью мы разобрались, и, возможно, кому-то достаточно даже 30 кадров, чтобы анимация стала плавной. Но с повышением частоты улучшается еще и четкость движущихся изображений. И это будет заметно любому:

На фотографии (это не скриншот) прекрасно заметна разница. С поднятием количества кадров в секунду уменьшается расстояние между отображаемыми кадрами, что в динамике влияет на резкость и отсутствие шлейфов у границ объектов. Это особенно заметно «на глаз», если матрица не из дорогих.

Такую разницу в качестве можно увидеть и другим способом. Для наглядности возьмем 60 Гц и 480 Гц:

Так выглядит объект в движении на мониторе с частотой 60 Гц. Как ни всматривайся, а объект все равно будет размытым.

А теперь то же видео при частоте обновления 480 Гц. Разница в четкости изображения просто завораживает.

Когда разгон вреден

Для комфортной картинки в играх мало монитора с высокой частотой развертки. Как мы уже говорили, для того чтобы избавиться от дерганного и рваного изображения в играх, необходимо синхронизировать работу видеокарты и монитора. А значит, стоит подумать о возможностях графического процессора.

Если графический адаптер не сможет обеспечить минимум 75 кадров в секунду при частоте монитора 75 Гц, то ни о каком комфорте и плавности речи быть не может. В таком случае, придется снижать настройки графики, получая более плавную картинку и повышенную четкость в динамике. Или же мириться с «мылом» в игре и играть на максимальных пресетах, но при 60 Гц. Тем не менее, есть категории пользователей, которым шустрая матрица просто необходима: