Запрет в robots txt страница что это

Руководство: как закрыть сайт от индексации в поисковых системах? Работа с файлом robots.txt

На стадии разработки и/или редизайна проекта бывают ситуации, когда лучше не допускать поисковых роботов на сайт или его копию. В этом случае рекомендуется закрыть сайт от индексации поисковых систем. Сделать это можно следующим образом:

Закрыть сайт от индексации очень просто, достаточно создать в корне сайта текстовый файл robots.txt и прописать в нём следующие строки:

User-agent: Yandex

Disallow: /

Такие строки закроют сайт от поискового робота Яндекса.

А таким образом можно закрыть сайт от всех поисковых систем (Яндекса, Google и других).

Как закрыть от индексации отдельную папку? #

Отдельную папку можно закрыть от поисковых систем в том же файле robots.txt с её явным указанием (будут скрыты все файлы внутри этой папки).

User-agent: *

Disallow: /folder/

Если какой-то отдельный файл в закрытой папке хочется отдельно разрешить к индексации, то используйте два правила Allow и Disallow совместно:

User-agent: *

Аllow: /folder/file.php

Disallow: /folder/

Как закрыть отдельный файл в Яндексе? #

User-agent: Yandex

Disallow: /folder/file.php

Как проверить, в индексе документ или нет? #

Проще всего осуществить проверку в рамках сервиса «Пиксель Тулс», бесплатный инструмент «Определение возраста документа в Яндексе» позволяет ввести URL списком. Если документ отсутствует в индексе, то в таблице будет выведено соответствующее значение.

Анализ проведён с помощью инструментов в сервисе Пиксель Тулс.

Как скрыть от индексации картинки? #

Картинки форматов jpg, png и gif могут быть запрещены к индексации следующими строчками в robots.txt:

User-Agent: *

Disallow: *.jpg

Disallow: *.png

Disallow: *.gif

Как закрыть поддомен? #

У каждого поддомена на сайте, в общем случае, имеется свой файл robots.txt. Обычно он располагается в папке, которая является корневой для поддомена. Требуется скорректировать содержимое файла с указанием закрываемых разделов с использованием директории Disallow. Если файл отсутствует — его требуется создать.

При использовании CDN-версии #

Как обращаться к другим поисковым роботам (список) #

У каждой поисковой системы есть свой список поисковых роботов (их несколько), к которым можно обращаться по имени в файле robots.txt. Приведем список основных из них (полные списки ищите в помощи Вебмастерам):

Прочие директивы в robots.txt #

Поисковая система Яндекс также поддерживает следующие дополнительные директивы в файле:

«Crawl-delay:» — задает минимальный период времени в секундах для последовательного скачивания двух файлов с сервера. Также поддерживается и большинством других поисковых систем. Пример записи: Crawl-delay: 0.5

«Clean-param:» — указывает GET-параметры, которые не влияют на отображение контента сайта (скажем UTM-метки или ref-ссылки). Пример записи: Clean-param: utm /catalog/books.php

«Sitemap:» — указывает путь к XML-карте сайта, при этом, карт может быть несколько. Также директива поддерживается большинством поисковых систем (в том числе Google). Пример записи: Sitemap: https://pixelplus.ru/sitemap.xml

Закрыть страницу и сайт с помощью meta-тега name=”robots” #

Также, можно закрыть сайт или заданную страницу от индексации с помощь мета-тега robots. Данный способ является даже предпочтительным и с большим приоритетом выполняется пауками поисковых систем. Для скрытия от индексации внутри зоны документа устанавливается следующий код:

Или (полная альтернатива):

С помощью meta-тега можно обращаться и к одному из роботов, используя вместо name=”robots” имя робота, а именно:

Для паука Google:

Или для Яндекса:

Запрет индексации в robots.txt

Чтобы убрать весь сайт или отдельные его разделы и страницы из поисковой выдачи Google, Яндекс и других поисковых систем, их нужно закрыть от индексации. Тогда контент не будет отображаться в результатах поиска. Рассмотрим, с помощью каких команд можно выполнить в файле robots.txt запрет индексации.

Зачем нужен запрет индексации сайта через robots.txt

Первое время после публикации сайта о нем знает только ограниченное число пользователей. Например, разработчики или клиенты, которым компания прислала ссылку на свой веб-ресурс. Чтобы сайт посещало больше людей, он должен попасть в базы поисковых систем.

Чтобы добавить новые сайты в базы, поисковые системы сканируют интернет с помощью специальных программ (поисковых роботов), которые анализируют содержимое веб-страниц. Этот процесс называется индексацией.

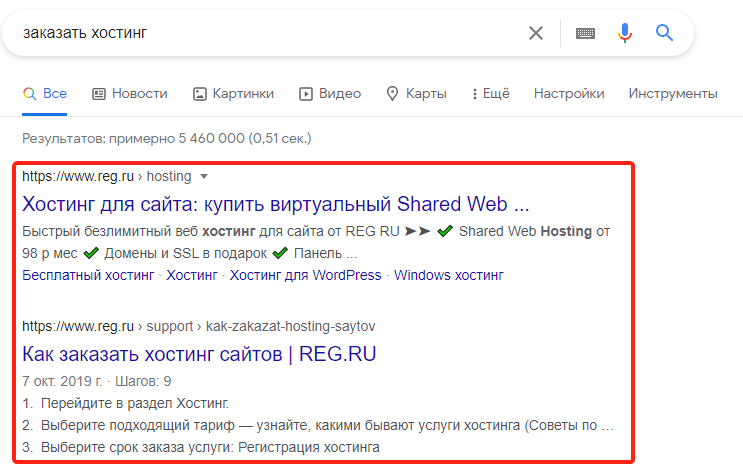

После того как впервые пройдет индексация, страницы сайта начнут отображаться в поисковой выдаче. Пользователи увидят их в процессе поиска информации в Яндекс и Google — самых популярных поисковых системах в рунете. Например, по запросу «заказать хостинг» в Google пользователи увидят ресурсы, которые содержат соответствующую информацию:

Однако не все страницы сайта должны попадать в поисковую выдачу. Есть контент, который интересен пользователям: статьи, страницы услуг, товары. А есть служебная информация: временные файлы, документация к ПО и т. п. Если полезная информация в выдаче соседствует с технической информацией или неактуальным контентом — это затрудняет поиск нужных страниц и негативно сказывается на позиции сайта. Чтобы «лишние» страницы не отображались в поисковых системах, их нужно закрывать от индексации.

Кроме отдельных страниц и разделов, веб-разработчикам иногда требуется убрать весь ресурс из поисковой выдачи. Например, если на нем идут технические работы или вносятся глобальные правки по дизайну и структуре. Если не скрыть на время все страницы из поисковых систем, они могут проиндексироваться с ошибками, что отрицательно повлияет на позиции сайта в выдаче.

Для того чтобы частично или полностью убрать контент из поиска, достаточно сообщить поисковым роботам, что страницы не нужно индексировать. Для этого необходимо отключить индексацию в служебном файле robots.txt. Файл robots.txt — это текстовый документ, который создан для «общения» с поисковыми роботами. В нем прописываются инструкции о том, какие страницы сайта нельзя посещать и анализировать, а какие — можно.

Прежде чем начать индексацию, роботы обращаются к robots.txt на сайте. Если он есть — следуют указаниям из него, а если файл отсутствует — индексируют все страницы без исключений. Рассмотрим, каким образом можно сообщить поисковым роботам о запрете посещения и индексации страниц сайта. За это отвечает директива (команда) Disallow.

Как запретить индексацию сайта

О том, где найти файл robots.txt, как его создать и редактировать, мы подробно рассказали в статье. Если кратко — файл можно найти в корневой папке. А если он отсутствует, сохранить на компьютере пустой текстовый файл под названием robots.txt и загрузить его на хостинг. Или воспользоваться плагином Yoast SEO, если сайт создан на движке WordPress.

Чтобы запретить индексацию всего сайта:

Добавьте в начало нужные строки.

Robots.txt и SEO: Всё что вам нужно знать

Статистика статьи

Показывает, сколько различных веб-сайтов ссылаются на этот контент. Как правило, чем больше сайтов ссылаются на вас, тем выше вы ранжируетесь в Google.

Показывает ежемесячный рассчетный поисковый трафик на эту статью по данным Ahrefs. Фактический поисковый трафик (по данным Google Analytics) обычно в 3–5 раз больше.

Количество ретвитов этой статьи в Twitter.

Поделиться этой статьей

Неправильная конфигурация файла robots.txt — очень распространённое явление даже сред/и опытных SEO специалистов.

В этом руководстве вы узнаете:

Что такое файл robots.txt?

Файл robots.txt сообщает поисковым системам о том, куда им можно и нельзя заходить на сайте.

В первую очередь, в нём перечисляется весь контент, который вы хотите скрыть от поисковых систем вроде Google. Некоторым поисковым системам (не Google) вы также можете указать как они должны сканировать доступный контент.

Большинство поисковых систем послушны. Они обычно не вламываются на сайт. При этом, некоторые не стесняются и обходят условные замки.

Google к ним не относится. Он соблюдает инструкции в файле robots.txt.

Просто имейте в виду, что некоторые поисковики не обращают на него никакого внимания.

Как выглядит файл robots.txt?

Вот базовый формат файла robots.txt:

Если вы никогда раньше не видели этих файлов, они могут вас напугать. Но синтаксис довольно прост. Вкратце, вы указываете правила для бота, указывая директивы для его user-agent.

Давайте изучим оба компонента подробнее.

User-agent

У каждой поисковой системы есть свой особый user-agent. В файле robots.txt вы можете указать инструкции для каждого из них. Есть сотни user-agent. Вот несколько полезных для SEO:

Чтобы обозначить инструкции для всех user-agent, используйте маску со звёздочкой (*).

Например, вы хотите запретить сканировать сайт всем роботам кроме Googlebot. Вот как это сделать:

В вашем файле robots.txt может быть много директив для всех user-agent, которые захотите. При этом, когда вы объявляете нового user-agent, он воспринимает только свои инструкции. Другими словами, если вы добавляете директивы для нескольких user-agent, то директивы для первого не будут работать для второго и последующих user-agent.

Исключением из правила будет случай, когда вы объявляете один и тот же user-agent более одного раза. В таком случае, робот будет следовать всем прописанным для него директивам инструкциям.

Краулеры следуют только тем правилам, которые прописаны под точным названием user-agent. Поэтому файл robots.txt выше блокирует всех роботов кроме Googlebot (и других роботов Google). Googlebot игнорирует более менее конкретное объявление user-agent.

Директивы

Директивы — это правила, которые должен соблюдать user-agent.

Поддерживаемые директивы

Вот список директив и примеры их использования, которые поддерживает Google.

Disallow

Используйте эту директиву, чтобы закрыть поисковым системам доступ к файлам и страницам по определённому пути. Например, если вы хотите закрыть доступ к блогу и всем его страницам для всех поисковых систем, ваш файл robots.txt будет выглядеть примерно так:

Allow

Эту директиву используют для того, чтобы позволить поисковым системам сканировать подпапку или страницу. Даже если в другом месте вы закрыли к ней доступ. Например, если вы хотите запретить поисковым системам сканировать каждый пост в блоге кроме одного, файл robots.txt будет выглядеть как-то так:

И Google, и Bing поддерживают эту директиву.

Если вы будете неосторожны, директивы allow и disallow могут легко конфликтовать друг с другом. В примере ниже мы запрещаем доступ к

В данном случае URL /blog/post-title/ одновременно разрешён и запрещён. Так какая же директива сработает?

Для Google и Bing главной будет та директива, у которой больше символов. В данном случае победит директива disallow.

Disallow: /blog/ (6 символов)

Allow: /blog (5 символов)

Если директивы allow и disallow одинаковой длины, то побеждает менее ограничивающая директива. В данном случае, это allow.

Важно то, что это касается только Google и Bing. Другие поисковые системы слушают первую подходящую директиву. В этом случае это disallow.

Sitemap

Используйте эту директиву, чтобы указать поисковым системам адрес вашей карты сайта. Если вы не знаете, что такое карта сайта, то они обычно перечисляют страницы, которые поисковые системы должны сканировать и индексировать.

Вот пример файла robots.txt c директивой Sitemap.

Насколько важно указывать карту (карты) сайта в файле robots.txt? Если вы её уже указали в поисковой консоли, то для Google этого достаточно. Однако другие поисковые системы, такие как Bing, смотрят расположение карты сайта в файле. Поэтому не стоит забывать об этой директиве.

Обратите внимание, что вам не нужно повторять директиву Sitemap для разных user-agent. Она работает для всех. Поэтому карту сайта лучше указывать в начале, или в конце файла robots.txt. Например:

Google поддерживает директиву sitemap, как и Ask, Bing и Yahoo.

Неподдерживаемые директивы

Вот несколько директив, которые Google больше не поддерживает. Некоторые из них он никогда не поддерживал.

Crawl-delay

Раньше эту директиву можно было использовать для указания задержки сканирования в секундах. Например, если вы хотели, чтоб Googlebot ждал 5 секунд после каждого сканирования, вы бы установили задержку в 5 секунд:

Google больше не поддерживает эту директиву, хотя Bing и Yandex поддерживают.

Тем не менее, будьте осторожны, указывая директиву. Особенно на большом сайте. Если вы выставите задержку в 5 секунд, вы ограничиваете роботов к 17280 URL в день. Если на вашем сайте миллионы страниц, то это не очень полезно. Но если у вас небольшой сайт, то сэкономите немного трафика.

Noindex

Эту директиву Google никогда официально не поддерживал. Однако до недавнего времени считалось, что у Google есть некоторый «код, который обрабатывает неподдерживаемые и неопубликованные правила (такие как noindex)». Поэтому, если вы хотите запретить Google индексировать все посты в вашем блоге, вы можете использовать следующую директиву:

Однако 1 сентября 2019 года Google дал понять, что эта директива не поддерживается. Если вы хотите исключить страницу или файл из поисковых систем, используйте вместо него тег meta robots или HTTP-заголовок x‑robots.

Nofollow

Это еще одна директива, которую Google никогда официально не поддерживал, и она использовалась для того, чтобы запретить поисковым системам переходить по ссылкам на страницах и файлах по определенному пути. Например, если вы хотели запретить Google переходить по всем ссылкам в вашем блоге, вы могли использовать следующую директиву:

Google объявил, что с 1 сентября 2019 года эта директива официально не поддерживается. Если сейчас вы хотите запретить переход по всем ссылкам на странице, следует использовать мета тег robots или заголовок x‑robots. Если вы хотите запретить Google переходить по определенным ссылкам на странице, используйте атрибут ссылки rel = “nofollow”.

Нужен ли вам файл robots.txt?

Многим сайтам, особенно маленьким, не обязательно иметь файл robots.txt.

Тем не менее, нет причины полностью от него отказываться. Он дает вам больше контроля над тем, куда поисковые системы могут и не могут заходить, и это может помочь с такими вещами, как:

Обратите внимание, что хотя Google обычно не индексирует веб-страницы, скрытые в файле robots.txt, это не гарантия того, что эти страницы не появятся в результатах поиска.

Как говорят в Google, если на контент ссылаются с других страниц в интернете, он может появиться в результатах поиска Google.

Как найти файл robots.txt?

Если у вас на сайте уже есть файл robots.txt, он будет доступен по адресу domain.com/robots.txt. Перейдите по URL в браузере. Если вы видите что-то подобное, то файл robots.txt у вас есть:

Как создать файл robots.txt

Продолжайте составлять директивы, пока не будете довольны тем, что имеете. Сохраните ваш файл как «robots.txt».

Продолжайте составлять директивы пока не напишите всё что нужно. Сохраните файл как “robots.txt.”

Также можно использовать генератор robots.txt вроде этого.

Преимущество такого инструмента в том, что он сводит к минимуму синтаксические ошибки. Это хорошо, потому что одна ошибка может привести к плачевным последствиям для SEO вашего сайта. Поэтому стоит быть осторожным.

Недостаток в том, что их сложнее настраивать.

Куда поместить файл robots.txt

Поместите файл robots.txt в корневой каталог поддомена, к которому он применяется. Например, чтобы контролировать сканирование на domain.com, файл robots.txt должен быть доступен по адресу domain.com/robots.txt.

Если вы хотите контролировать сканирование на поддомене вроде blog.domain.com, тогда файл robots.txt должен быть доступен по адресу blog.domain.com/robots.txt.

Лучшие практики robots.txt

Чтобы избежать распространённых ошибок, следуйте этим правилам.

Каждую директиву прописывайте с новой строки

Каждая директива должна быть прописана на новой строке. Иначе поисквые системы её не поймут.

Плохо:

Хорошо:

Используйте маски для упрощения

Маски (*) можно использовать не только для определения всех user-agent, но и для шаблонов URL адресов при объявлении директив. Например, если вы хотите запретить поисковым системам доступ к URL-адресам категорий товаров с параметрами на вашем сайте, вы можете перечислить их следующим образом:

Но это не очень эффективно. Было бы использовать маску, как здесь:

В этом примере поисковым системам запрещается сканировать все URL-адреса в подпапке /product/ со знаком вопроса. Другими словами, любые URL с параметрами категории товаров.

Используйте знак “$” для определения окончания URL адреса

Используйте каждый user-agent не больше одного раза

Если вы указали один и тот же user-agent несколько раз, Google поймёт. Он просто объединит все правила из разных мест в одно и будет следовать им всем. Например, если в вашем файле robots.txt были следующие user-agent и директивы…

… Googlebot не будет сканировать ни одну из подпапок.

Тем не менее, не стоит прописывать user-agent больше одного раза, потому что так вы будете меньше путаться. Другими словами, если всё будет упорядочено и просто, то вы не будете совершать критических ошибок.

Будьте конкретными, чтобы избежать случайных ошибок

Если дать нечёткие инструкции при составлении директив, вы можете легко совершить ошибку. Это может иметь катастрофические последствия для вашего SEO. Предположим, что у вас есть мультиязычный сайт и вы работаете над немецкой версией, которая будет доступна в подпапке /de/.

Поскольку она ещё не полностью готова, вы хотите закрыть поисковым системам доступ к ней.

Файл robots.txt, который вы видите ниже запрещает поисковым системам заходить в эту подпапку и сканировать что-либо в ней:

В данном случае решение простое: добавить в конце косую черту.

Используйте комментарии, чтобы люди могли понимать ваш robots.txt

Комментарии помогают разработчикам понимать ваш файл robots.txt и, возможно, даже вам самим в будущем. Чтобы добавить комментарий, начните строку со знака хеша (#).

Роботы будут игнорировать все строки, которые начинаются с этого символа.

Для каждого поддомена используйте отдельный файл robots.txt

Robots.txt контролирует сканирование только на поддомене, где он размещен. Если вы хотите контролировать сканирование на другом поддомене, вам понадобится отдельный файл robots.txt.

Например, если ваш основной сайт находится на domain.com, а ваш блог — на blog.domain.com, вам понадобятся два файла robots.txt. Один должен идти в корневой каталог основного домена, а другой — в корневой каталог блога.

Примеры файлов robots.txt

Ниже приведены несколько примеров файлов robots.txt. Я их привожу только для примера, но если какой-то вам подходит, скопируйте его в текстовый документ, сохраните как «robots.txt» и загрузите в соответствующий каталог.

Полный доступ для всех роботов

Нет доступа всем роботам

Заблокировать доступ к одной подпапке для всех роботов

Заблокировать доступ к одной подпапке для всех роботов (оставить доступным один файл)

Заблокировать один файл для всех ботов

Заблокировать один тип файлов (PDF) для всех ботов

Запретить сканирование URL адресов с параметрами только для Googlebot

Как найти ошибки в файле robots.txt

В файле robots.txt очень легко допустить ошибку, поэтому стоит за этим следить особенно внимательно.

Для этого следует регулярно проверять отчёт “Покрытие” в поисковой консоли. Ниже мы привели несколько примеров ошибок, которые вы можете увидеть, рассказали что они значат и как их исправить.

Вставьте URL-адрес в инструмент Google для проверки URL-адресов в консоли поиска. Если он заблокирован файлом robots.txt, вы должны увидеть что-то вроде этого:

Доступ к отправленному URL заблокирован в файле robots.txt

Это означает, что по крайней мере один из URL-адресов в карте сайта заблокирован в файле robots.txt.

Если вы правильно создали карту сайта и исключили каноникализированные, noindex и перенаправленные страницы, robots.txt не должен блокировать отправленные страницы. Если они заблокированы, выясните, что это за страницы, затем настройте файл robots.txt соответствующим образом, чтобы удалить запрет для этой страницы.

Чтобы узнать, какая директива блокирует контент, можно использовать инструмент для тестирования robots.txt от Google. Только будьте осторожны. Не допускайте ошибок, которые влияют на другие страницы и файлы.

Заблокированы в файле robots.txt

Это означает, что у вас есть контент, заблокированный в файле robots.txt, который в настоящее время не индексируется в Google.

Если это важный контент и его нужно проиндексировать, удалите запрет сканирования в файле robots.txt. (Также стоит убедиться, что контент не запрещён к индексированию тегом noindex). Если вы запретили доступ к контенту в файле robots.txt чтобы исключить его из индекса Google, удалите запрет сканирования и используйте вместо него метатег robots или x‑robots-header. Это единственный способ гарантированно исключить контент из индекса Google.

Проиндексировано, несмотря на блокировку в файле robots.txt

Это означает, что часть контента, заблокированного robots.txt, все еще находится в индексе Google.

Повторюсь, что если вы хотите исключить контент из результатов поиска Google, robots.txt вам не поможет. Удалите запрет на сканирование и вместо этого используйте мета-тег robots или HTTP-заголовок x‑robots-tag.

Если вы случайно заблокировали этот контент и хотите оставить его в индексе Google, удалите запрет на сканирование в файле robots.txt. Это поможет улучшить видимость контента в поиске Google.

Вот несколько часто задаваемых вопросов, которые не подходят ни одному разделу в нашем руководстве. Если чего-то не хватает, сообщите нам в комментариях и мы обязательно это добавим.

Какой максимальный размер файла robots.txt?

Где находится файл robots.txt в WordPress?

Там же: domain.com/robots.txt.

Как отредактировать файл robots.txt в WordPress?

Либо вручную, либо воспользоваться одним из SEO плагинов для WordPress наподобие Yoast. Он позволяет редактировать файл прямо из админпанели WordPress.

Что будет, если в файле robots.txt запретить доступ к контенту с тегои noindex?

Google не сможет увидеть директиву noindex, потому что он не будет сканировать страницу

А вы знали что нет смысла запрещать доступ к странице с помощью robots.txt disallow & и тегом noindex, потому что Googlebot не увидит noindex? pic.twitter.com/N4639rCCWt

Заключение

Robots.txt — это простой, но важный файл. Используйте его с умом и увидите позитивное влияние на SEO. Используйте его как попало и, ну, сами пожалеете об этом.

Остались вопросы? Оставьте комментарий или напишите мне в Twitter.

Какие страницы следует закрывать от индексации

Индексирование сайта – это процесс, с помощью которого поисковые системы, подобные Google и Yandex, анализируют страницы веб-ресурса и вносят их в свою базу данных. Индексация выполняется специальным ботом, который заносит всю необходимую информацию о сайте в систему – веб-страницы, картинки, видеофайлы, текстовый контент и прочее. Корректное индексирование сайта помогает потенциальным клиентам легко найти нужный сайт в поисковой выдаче, поэтому важно знать обо всех тонкостях данного процесса.

В сегодняшней статье я рассмотрю, как правильно настроить индексацию, какие страницы нужно открывать для роботов, а какие нет.

Почему важно ограничивать индексацию страниц

Заинтересованность в индексации есть не только у собственника веб-ресурса, но и у поисковой системы – ей необходимо предоставить релевантную и, главное, ценную информацию для пользователя. Чтобы удовлетворить обе стороны, требуется проиндексировать только те страницы, которые будут интересны и целевой аудитории, и поисковику.

Прежде чем переходить к списку ненужных страниц для индексации, давайте рассмотрим причины, из-за которых стоит запрещать их выдачу. Вот некоторые из них:

В краулинговый бюджет входят: взломанные страницы, файлы CSS и JS, дубли, цепочки редиректов, страницы со спамом и прочее.

Что нужно скрывать от поисковиков

В первую очередь стоит ограничить индексирование всего сайта, который еще находится на стадии разработки. Именно так можно уберечь базу данных поисковых систем от некорректной информации. Если ваш веб-ресурс давно функционирует, но вы не знаете, какой контент стоит исключить из поисковой выдачи, то рекомендуем ознакомиться с нижеуказанными инструкциями.

PDF и прочие документы

Часто на сайтах выкладываются различные документы, относящиеся к контенту определенной страницы (такие файлы могут содержать и важную информацию, например, политику конфиденциальности).

Рекомендуется отслеживать поисковую выдачу: если заголовки PDF-файлов отображаются выше в рейтинге, чем страницы со схожим запросом, то их лучше скрыть, чтобы открыть доступ к наиболее релевантной информации. Отключить индексацию PDF и других документов вы можете в файле robots.txt.

Разрабатываемые страницы

Стоит всегда избегать индексации разрабатываемых страниц, чтобы рейтинг сайта не снизился. Используйте только те страницы, которые оптимизированы и наполнены уникальным контентом. Настроить их отображение можно в файле robots.txt.

Копии сайта

Если вам потребовалось создать копию веб-ресурса, то в этом случае также необходимо все правильно настроить. В первую очередь укажите корректное зеркало с помощью 301 редиректа. Это позволит оставить прежний рейтинг у исходного сайта: поисковая система будет понимать, где оригинал, а где копия. Если же вы решитесь использовать копию как оригинал, то делать это не рекомендуется, так как возраст сайта будет обнулен, а вместе с ним и вся репутация.

Веб-страницы для печати

Иногда контент сайта требует уникальных функций, которые могут быть полезны для клиентов. Одной из таких является «Печать», позволяющая распечатать необходимые страницы на принтере. Создание такой версии страницы выполняется через дублирование, поэтому поисковые роботы могут с легкостью установить копию как приоритетную. Чтобы правильно оптимизировать такой контент, необходимо отключить индексацию веб-страниц для печати. Сделать это можно с использованием AJAX, метатегом либо в файле robots.txt.

Формы и прочие элементы сайта

Большинство сайтов сейчас невозможно представить без таких элементов, как личный кабинет, корзина пользователя, форма обратной связи или регистрации. Несомненно, это важная часть структуры веб-ресурса, но в то же время она совсем бесполезна для поисковых запросов. Подобные типы страниц необходимо скрывать от любых поисковиков.

Страницы служебного пользования

Формы авторизации в панель управления и другие страницы, используемые администратором сайта, не несут никакой важной информации для обычного пользователя. Поэтому все служебные страницы следует исключить из индексации.

Личные данные пользователя

Вся персональная информация должна быть надежно защищена – позаботиться о ее исключении из поисковой выдачи нужно незамедлительно. Это относится к данным о платежах, контактам и прочей информации, идентифицирующей конкретного пользователя.

Страницы с результатами поиска по сайту

Как и в случае со страницами, содержащими личные данные пользователей, индексация такого контента не нужна: веб-страницы результатов полезны для клиента, но не для поисковых систем, так как содержат неуникальное содержание.

Сортировочные страницы

Контент на таких веб-страницах обычно дублируется, хоть и частично. Однако индексация таких страниц посчитается поисковыми системами как дублирование. Чтобы снизить риск возникновения таких проблем, рекомендуется отказаться от подобного контента в поисковой выдаче.

Пагинация на сайте

Пагинация – без нее сложно представить существование любого крупного веб-сайта. Чтобы понять ее назначение, приведу небольшой пример: до появления типичных книг использовались свитки, на которых прописывался текст. Прочитать его можно было путем развертывания (что не очень удобно). На таком длинном холсте сложно найти нужную информацию, нежели в обычной книге. Без использования пагинации отыскать подходящий раздел или товар также проблематично.

Пагинация позволяет разделить большой массив данных на отдельные страницы для удобства использования. Отключать индексирование для такого типа контента нежелательно, требуется только настроить атрибуты rel=”canonical”, rel=”prev” и rel=”next”. Для Google нужно указать, какие параметры разбивают страницы – сделать это можно в Google Search Console в разделе «Параметры URL».

Помимо всего вышесказанного, рекомендуется закрывать такие типы страниц, как лендинги для контекстной рекламы, страницы с результатами поиска по сайту и поиск по сайту в целом, страницы с UTM-метками.

Какие страницы нужно индексировать

Ограничение страниц для поисковых систем зачастую становится проблемой – владельцы сайтов начинают с этим затягивать или случайно перекрывают важный контент. Чтобы избежать таких ошибок, рекомендуем ознакомиться с нижеуказанным списком страниц, которые нужно оставлять во время настройки индексации сайта.

Соблюдение индексации таких страниц может значительно улучшить поисковую выдачу, если ранее оптимизация не проводилась.

Как закрыть страницы от индексации

Мы детально рассмотрели список всех страниц, которые следует закрывать от поисковых роботов, но о том, как это сделать, прошлись лишь вскользь – давайте это исправлять. Выполнить это можно несколькими способами: с помощью файла robots.txt, добавления специальных метатегов, кода, сервисов для вебмастеров, а также с использованием дополнительных плагинов. Рассмотрим каждый метод более детально.

Способ 1: Файл robots.txt

Данный текстовый документ – это файл, который первым делом посещают поисковики. Он предоставляет им информацию о том, какие страницы и файлы на сайте можно обрабатывать, а какие нет. Его основная функция – сократить количество запросов к сайту и снизить на него нагрузку. Он должен удовлетворять следующим критериям:

Прежде чем переходить к редактированию файла, рекомендую обратить внимание на ограничивающие факторы.

Файл robots.txt включает в себя такие параметры, как:

Теперь давайте рассмотрим, как можно отключить индексацию определенных страниц или всего сайта. Все пути в примерах – условные.

Пропишите, чтобы исключить индексацию сайта для всех роботов: