Набор параметров данных необходимых для применения метода это

Анализ данных — основы и терминология

В этой статье я бы хотел обсудить базовые принципы построения практического проекта по (т. н. «интеллектуальному») анализу данных, а также зафиксировать необходимую терминологию, в том числе русскоязычную.

Анализ данных — это область математики и информатики, занимающаяся построением и исследованием наиболее общих математических методов и вычислительных алгоритмов извлечения знаний из экспериментальных (в широком смысле) данных; процесс исследования, фильтрации, преобразования и моделирования данных с целью извлечения полезной информации и принятия решений.

Говоря чуть более простым языком, я бы предложил понимать под анализом данных совокупность методов и приложений, связанных с алгоритмами обработки данных и не имеющих четко зафиксированного ответа на каждый входящий объект. Это будет отличать их от классических алгоритмов, например реализующих сортировку или словарь. От конкретной реализации классического алгоритма зависит время его выполнения и объем занимаемой памяти, но ожидаемый результат его применения строго зафиксирован. В противоположность этому мы ожидаем от нейросети, распознающей цифры, ответа 8 при входящей картинке, изображающей рукописную восьмерку, но не можем требовать этого результата. Более того, любая (в разумном смысле этого слова) нейросеть будет иногда ошибаться на тех или иных вариантах корректных входных данных. Будем называть такую постановку задачи и применяющиеся при ее решении методы и алгоритмы недетерминистическими (или нечеткими) в отличии от классических (детерминистических, четких).

Алгоритмы и эвристики

Описанную задачу распознавания цифр можно решать пытаясь самостоятельно подобрать функцию, реализующую соответствующее отображение. Получится, скорее всего, не очень быстро и не очень хорошо. С другой стороны, можно прибегнуть к методам машинного обучения, то есть воспользоваться вручную размеченной выборкой (или, в других случаях, теми или иными историческими данными) для автоматического подбора решающей функции. Таким образом, здесь и далее (обобщенным) алгоритмом машинного обучения я буду называть алгоритм, так или иначе на основе данных формирующий недетерминистический алгоритм, решающий ту или иную задачу. (Недетерминистичность полученного алгоритма нужна для того, чтобы под определение не подпадал справочник, использующий предварительно подгруженные данные или внешний API).

Таким образом, машинное обучение является наиболее распространенным и мощным (но, тем не менее, не единственным) методом анализа данных. К сожалению, алгоритмов машинного обучения, хорошо обрабатывающих данные более или менее произвольной природы люди пока не изобрели и поэтому специалисту приходится самостоятельно заниматься предобработкой данных для приведения их в пригодный для применения алгоритма вид. В большинстве случаев такая предобработка называется фичеселектом (англ. feature selection) или препроцессингом. Дело в том, что большинство алгоритмов машинного обучения принимают на вход наборы чисел фиксированной длины (для математиков — точки в ). Однако сейчас также широко используются разнообразные алгоритмы на основе нейронных сетей, которые умеют принимать на вход не только наборы чисел, но и объекты, имеющие некоторые дополнительные, главным образом геометрические, свойства, такие как изображения (алгоритм учитывает не только значения пикселей, но и их взаимное расположение), аудио, видео и тексты. Тем не менее, некоторая предобработка как правило происходит и в этих случаях, так что можно считать, что для них фичеселект заменяется подбором удачного препроцессинга.

Алгоритмом машинного обучения с учителем (в узком смысле этого слова) можно назвать алгоритм (для математиков — отображение), который берет на вход набор точек в (еще называются примерами или samples)

и меток (значений, которые мы пытаемся предсказать)

, а на выходе дает алгоритм (=функцию)

, уже сопоставляющий конкретное значение

любому входу

, принадлежащему пространству примеров. Например, в случае упомянутой выше нейросети, распознающей цифры, с помощью специальной процедуры на основе обучающей выборки устанавливаются значения, соответствующие связям между нейронами, и с их помощью на этапе применения вычисляется то или иное предсказание для каждого нового примера. Кстати, совокупность примеров и меток называется обучающей выборкой.

Список эффективных алгоритмов машинного обучения с учителем (в узком смысле) строго ограничен и почти не пополняется несмотря на активные исследования в этой области. Однако для правильного применения этих алгоритмов требуется опыт и подготовка. Вопросы эффективного сведения практической задачи к задаче анализа данных, подбора списка фичей или препроцессинга, модели и ее параметров, а также грамотного внедрения непросты и сами по себе, не говоря уже о работе над ними в совокупности.

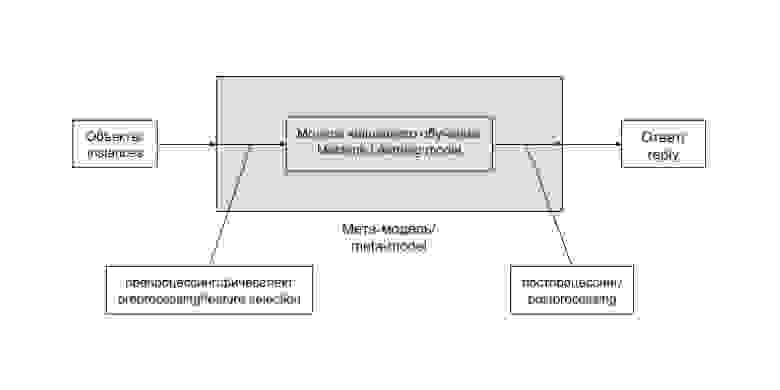

Общая схема решения задачи анализа данных при использовании метода машинного обучения выглядит таким образом:

Цепочку «препроцессинг — модель машинного обучения — постпроцессинг» удобно выделять в единую сущность. Часто такая цепочка остается неизменной и лишь регулярно дообучается на новопоступивших данных. В некоторых случаях, особенно на ранних этапах развития проекта, ее содержимое заменяется более или менее сложной эвристикой, не зависящей напрямую от данных. Бывают и более хитрые случаи. Заведем для такой цепочки (и возможных ее вариантов) отдельный термин и будем называть мета-моделью (meta-model). В случае эвристики она редуцируется до следующей схемы:

Эвристика — это просто вручную подобранная функция, не использующая продвинутых методов, и, как правило, не дающая хорошего результата, но приемлемая в определенных случаях, например на ранних стадиях развития проекта.

Задачи машинного обучения с учителем

В зависимости от постановки, задачи машинного обучения делят на задачи классификации, регрессии и логистической регрессии.

Классификация — постановка задачи при которой требуется определить, какому классу из некоторого четко заданного списка относится входящий объект. Типичным и популярным примером является уже упоминавшееся выше распознавание цифр, в ней каждому изображению нужно сопоставить один из 10 классов, соответствующий изображенной цифре.

Регрессия — постановка задачи, при которой требуется предсказать некоторую количественную характеристику объекта, например цену или возраст.

Логистическая регрессия сочетает свойства перечисленных выше двух постановок задач. В ней задаются совершившиеся события на объектах, а требуется предсказать их вероятности на новых объектах. Типичным примером такой задачи является задача предсказания вероятности перехода пользователя по рекомендательной ссылке или рекламному объявлению.

Выбор метрики и валидационная процедура

Метрика качества предсказания (нечеткого) алгоритма — это способ оценить качество его работы, сравнить результат его применения с действительным ответом. Более математично — это функция, берущая на вход список предсказаний и список случившихся ответов

, а возвращающая число соответствующее качеству предсказания. Например в случае задачи классификации самым простым и популярным вариантом является количество несовпадений

, а в случае задачи регрессии — среднеквадратичное отклонение

. Однако в ряде случаев из практических соображений необходимо использовать менее стандартные метрики качества.

Прежде чем внедрять алгоритм в работающий и взаимодействующий с реальными пользователями продукт (или передавать его заказчику), хорошо бы оценить, насколько хорошо этот алгоритм работает. Для этого используется следующий механизм, называемый валидационной процедурой. Имеющаяся в распоряжении размеченная выборка разделяется на две части — обучающую и валидационную. Обучение алгоритма происходит на обучающей выборке, а оценка его качества (или валидация) — на валидационной. В том случае, если мы пока не используем алгоритм машинного обучения, а подбираем эвристику, можно считать, что вся размеченная выборка, на которой мы оцениваем качество работы алгоритма является валидационной, а обучающая выборка пуста — состоит из 0 элементов.

Типичный цикл развития проекта

В самых общих чертах цикл развития проекта по анализу данных выглядит следующим образом.

Заключение

На этом пока все, следующий раз мы обсудим какие конкретно алгоритмы применяются для решения задач классификации, регрессии и логистической регрессии, а о том, как сделать базовое исследование задачи и подготовить его результат для использования прикладным программистом уже можно почитать здесь.

Сколько обучающих данных необходимо для машинного обучения

Количество необходимых вам данных зависит от сложности задачи и от сложности выбранного вами алгоритма. Это факт, но это вам не поможет, если вы на острие проекта по машинному обучению. Джейсон Браунли опубликовал ответы на часто задаваемые вопросы.

Сколько данных мне необходимо?

Джейсон не может ответить на этот вопрос ни конкретно вам, ни кому-то еще. Но может дать несколько способов взглянуть на данную проблему.

Джейсон изложил комплекс методик, которые могут быть использованы для определения количества обучающих данных, необходимых для применения машинного обучения к вашей задаче.

Возможно, что один или несколько из этих методов помогут вам понять сложность вопроса и то, как тесно он сочетается с проблемой индукции, которую вы пытаетесь решить.

Давайте разберемся в этом глубже.

Почему вы задаёте этот вопрос?

Важно знать, почему вы спрашиваете о необходимом размере обучающей выборки.

Ответ может повлиять на ваш следующий шаг.

В более общем плане, по ходу может возникнуть больше вопросов, таких как:

На эти вопросы должны дать ответ предложения, описанные в данной статье.

На практике, для получения ответов на эти вопросы, используются кривые обучения (смотрите ниже), методы ресемплинга на небольших выборках (например, k-fold перекрёстную проверку и бутсрэппинг) и добавляя доверительные интервалы к конечным результатам.

1. Зависит от; Никто не может сказать вам

Никто не может сказать вам, сколько нужно данных для вашей прогностической модели.

Ответ неизвестен: это трудноразрешимая задача, решение которой можно найти при помощи эмпирического исследования.

Количество данных, необходимых для машинного обучения, зависит от многих факторов, таких как:

Это наша точка отсчёта.

А «зависит от» — это ответ, который большая часть практиков даст вам, когда вы впервые зададите этот вопрос.

2. Основываясь на аналогии

Множество людей до вас проделало большую работу над решением прикладных задач машинного обучения.

Некоторые из них опубликовали свои результаты.

Вполне возможно, что вы сможете взглянуть на изучение проблем, похожих на ваши, чтобы оценить количество требуемых данных.

Также, довольно распространённым явлением являются исследования влияния размера выборки данных на эффективность алгоритма. Такие исследования, возможно, дадут вам информацию о том, сколько данных нужно использовать для конкретного алгоритма.

Можно взять среднее значение из нескольких исследований.

Поищите статьи в Google, Google Scholar, и Arxiv.

3. Используйте экспертные знания в области

Вам нужна выборка данных по вашей задаче, представляющая проблему, которую вы пытаетесь решить.

В общем, примеры должны быть независимы и одинаково распределены.

Помните, что в машинном обучении мы изучаем функцию сопоставления входных данных с выходными данными. Изучаемая сопоставляющая функция будет хороша настолько, насколько будут хороши данные, которые вы предоставите ей для обучения.

Это значит, что данных должно быть достаточно для верного понимания взаимосвязей, существующих как между функциями ввода, так и между функциями ввода и вывода.

Используйте ваши знания в области или найдите эксперта в нужной области, и порассуждайте о масштабе данных, необходимых для разумного охвата полезной сложности задачи.

4. Используйте статистическую эвристику

Существуют методы статистической эвристики, которые позволят вам определить подходящий размер выборки.

Большая часть эвристических методов, которые встречал Джейсон, предназначались для классификации задач как функции количества классов, входной функции или параметров модели. Некоторые их них кажутся жесткими, другие – полностью специальными.

Вот несколько примеров, которые вы можете рассмотреть:

Все они выглядят, как специальные коэффициенты масштабирования.

В теоретической работе по данной теме, классификатор (например, метод k-ближайших соседей) часто противопоставляется оптимальному Байесовскому решающему правилу и сложность характеризуется в контексте проклятия размерности; которое говорит о том, что, с увеличением количества входных функций, экспоненциально растет сложность задачи.

Выводы говорят о том, что следует избегать применения локальных методов (вроде метода k-ближайших соседей) для редких выборок, при задачах с большой размерностью (к примеру, малое количество выборок и множество входных функций).

Для более детального обсуждения по данной теме, смотрите:

5. Для нелинейных алгоритмов необходимо больше данных

Более эффективные алгоритмы машинного обучения называются нелинейными алгоритмами.

Они, по определению, способны изучать комплексные нелинейные взаимосвязи между входными и выходными функциями. Вполне возможно, что вы используете подобные алгоритмы или намереваетесь их использовать.

Данные алгоритмы часто являются более гибкими и даже непараметрическими (они способны определить, сколько параметров необходимо для моделирования вашей задачи, в дополнение к значениям данных параметров). Также они очень вариативны – это значит, что прогнозы варьируются, основываясь на конкретных, использованных для их обучения, данных. Это дополнительная гибкость и эффективность достигается за счёт потребности в большем количестве данных, часто – в очень большом количестве данных.

Фактически, некоторые нелинейные алгоритмы, вроде методов глубокого обучения, могу продолжать совершенствоваться по мере добавления вами новых данных.

Когда линейному алгоритму, для получения хорошей эффективности, нужно сотни примеров на класс, для нелинейного, вроде случайного леса (random forest) или искусственной нейронной сети, могут потребоваться тысячи.

6. Оценка размера набора данных против навыка модели

Распространённым явлением является разработка нового алгоритма машинного обучения для демонстрации и даже пояснения эффективности алгоритма под воздействием количества данных или сложности задачи.

Данные исследования могут быть, а могут и не быть проведены и опубликованы автором алгоритма, а также могут как существовать, так и не существовать для алгоритмов или задач, с которыми вы работаете.

Можно провести ваше собственное исследование, используя доступные вам данные и один хорошо функционирующий алгоритм, вроде случайного леса.

Разработайте исследование, которое оценивало бы навык модели, в противопоставлении его размеру выборки данных.

Результат отобразите в виде линейного графика, где ось x – это размер обучающей выборки, а ось y – навык модели. Это даст вам понимание того, как размер данных влияет на навык модели в вашей конкретной задаче.

С его помощью вы можете спроектировать количество данных, необходимых для разработки хорошо обученной модели, или, возможно, как мало данных вам в действительности нужно до достижения точки снижения результативности.

Рекомендуется использование данного подхода для разработки надёжных моделей в контексте всестороннего понимания задачи.

7. Наивная приблизительная оценка

Для применения алгоритмов машинного обучения вам понадобится много данных.

Зачастую, вам потребуется больше данных, чем могло бы потребоваться в классической статистике.

Достаньте и используйте столько данных, сколько сможете.

Если с нужен ответа на этот вопрос — с нулевыми знаниями о специфике вашей задачи:

Опять же, это только приблизительная оценка для такого случая, но если вам необходимо – это может быть точкой отсчета. Так что беритесь за дело!

8. Соберите больше данных (несмотря ни на что!?)

Большие массивы данных часто обсуждаются в применении к машинному обучению, но вам, для вашей прогностической модели, может и не понадобиться так много данных.

Некоторые задачи требуют использования большого массива данных, всех данных, что у вас есть. Например, простой статистический машинный перевод:

Если вы занимаетесь традиционным прогностическим моделированием, то, скорее всего, вы столкнётесь с точкой снижения эффективности размера обучающей выборки, так что вам надо будет изучить вашу задачу и избранные модели для определения этой точки.

Имейте в виду, что машинное обучение – это процесс индукции. Модель может охватывать только то, что уже видела. Если ваши обучающие данные не включают в себя крайние случаи, они, очень вероятно, не будут поддерживаться моделью.

Не откладывайте; беритесь за дело

А теперь, перестаньте готовиться к моделированию задачи и начните её моделировать.

Не позволяйте проблеме размера обучающей выборки помешать вам начать работу над прогностическим моделированием задачи.

Во многих случаях именно этот вопрос является причиной прокрастинации.

Соберите столько данных, сколько сможете; используйте то, что у вас есть, и узнаете, насколько эффективны модели для вашей задачи.

Что-нибудь узнайте, затем примите меры для лучшего понимания полученного с помощью дальнейшего анализа, расширьте имеющиеся данные, дополнив их, или соберите больше данных из вашей области.

Дальнейшее чтение

Этот раздел предоставляет больше ресурсов по данной теме, если вы хотите в неё углубиться.

Существует множество обсуждений данного вопроса на Q&A сайтах, вроде Quora, StackOverflow и CrossValidated. Ниже есть несколько избранных примеров, которые могут помочь:

По этому вопросу есть несколько отличных статистических исследований:

Другие статьи по теме:

Подведем итог

В этой статье вы открыли для себя набор способов обдумать и поразмыслить о проблемах ответа на распространённый вопрос:

Сколько данных мне нужно для машинного обучения?

Сколько данных обучения требуется для машинного обучения?

Дата публикации 2017-07-24

Количество необходимых вам данных зависит как от сложности вашей проблемы, так и от сложности выбранного вами алгоритма.

Это факт, но он не поможет вам, если вы находитесь в самом конце проекта машинного обучения.

Общий вопрос, который мне задают:

Сколько данных мне нужно?

Я не могу ответить на этот вопрос непосредственно для вас или для кого-либо. Но я могу дать вам несколько способов обдумать этот вопрос.

В этом посте я изложу набор методов, которые вы можете использовать, чтобы подумать о том, сколько учебных данных вам нужно, чтобы применить машинное обучение к вашей проблеме.

Я надеюсь, что один или несколько из этих методов могут помочь вам понять сложность вопроса и то, как он тесно связан с сущностью проблемы индукции, которую вы пытаетесь решить.

Давайте погрузимся в это.

Примечание. Есть ли у вас собственные эвристические методы для определения объема данных, необходимых для машинного обучения? Пожалуйста, поделитесь ими в комментариях.

Почему вы задаете этот вопрос?

Важно знать, почему вы спрашиваете о необходимом размере учебного набора данных.

Ответ может повлиять на ваш следующий шаг.

В более общем плане, у вас могут возникнуть другие пешеходные вопросы, такие как:

Возможно, именно эти последние вопросы и будут рассмотрены в предложениях в этом посте.

На практике я сам отвечаю на этот вопрос, используя кривые обучения (см. Ниже), используя методы повторной выборки для небольших наборов данных (например, перекрестную проверку в k-кратном порядке и начальную загрузку) и добавляя доверительные интервалы к конечным результатам.

По какой причине вы спрашиваете о количестве образцов, необходимых для машинного обучения?

Пожалуйста, дайте мне знать в комментариях.

Итак, сколько данных вам нужно?

1. Это зависит; Никто не может сказать вам

Никто не может сказать вам, сколько данных вам нужно для вашей задачи прогнозного моделирования.

Это непостижимо: неразрешимая проблема, ответы на которую вы должны найти путем эмпирического исследования.

Объем данных, необходимых для машинного обучения, зависит от многих факторов, таких как:

Это наша отправная точка.

А также “это зависит»- это ответ, который большинство практикующих даст вам в первый раз, когда вы спросите.

2. Причина по аналогии

Многие люди работали над многими проблемами прикладного машинного обучения перед вами.

Некоторые из них опубликовали свои результаты.

Возможно, вы можете посмотреть на исследования проблем, похожих на вашу, как на оценку объема данных, которые могут потребоваться.

Точно так же обычно проводят исследования того, как производительность алгоритма масштабируется с размером набора данных. Возможно, такие исследования могут сообщить вам, сколько данных вам требуется для использования определенного алгоритма.

Возможно, вы можете усреднить по нескольким исследованиям.

Поиск документов в Google,Google ученый, а такжеArxiv,

3. Используйте экспертизу домена

Вам нужен образец данных о вашей проблеме, который представляет проблему, которую вы пытаетесь решить.

В общем, примеры должны быть независимыми и одинаково распределенными.

Помните, что в машинном обучении мы учим функцию сопоставления входных данных с выходными данными. Изученная функция сопоставления будет полезна только тем данным, которые вы предоставляете для изучения.

Это означает, что должно быть достаточно данных для разумного захвата отношений, которые могут существовать как между входными объектами, так и между входными объектами и выходными объектами.

Используйте свои знания предметной области или найдите эксперта по домену и расскажите о домене и масштабе данных, которые могут потребоваться для обоснованного отражения полезной сложности проблемы.

4 Используйте статистическую эвристику

Существуют статистические эвристические методы, которые позволяют рассчитать подходящий размер выборки.

Большая часть эвристики, которую я видел, касалась задач классификации в зависимости от количества классов, входных объектов или параметров модели. Некоторые эвристики кажутся строгими, другие кажутся совершенно случайными.

Вот несколько примеров, которые вы можете рассмотреть:

Все они выглядят как специальные коэффициенты масштабирования для меня.

Вы использовали какую-либо из этих эвристик?

Как прошло? Дай мне знать в комментариях.

В теоретической работе по этой теме (не в моей области знаний!) Классификатор (например, k-ближайшие соседи) часто противопоставляется оптимальному байесовскому правилу принятия решений, а сложность характеризуется в контексте проклятия размерности; это означает экспоненциальное увеличение сложности задачи по мере увеличения количества входных объектов.

Результаты показывают, что следует избегать локальных методов (например, k-ближайших соседей) для разреженных выборок из задач большой размерности (например, несколько выборок и много входных объектов).

5. Нелинейным алгоритмам нужно больше данных

Более мощные алгоритмы машинного обучения часто называют нелинейными алгоритмами.

По определению они могут изучать сложные нелинейные отношения между входными и выходными функциями. Вы можете очень хорошо использовать эти типы алгоритмов или намереваться их использовать.

Эти алгоритмы часто являются более гибкими и даже непараметрическими (они могут определить, сколько параметров требуется для моделирования вашей проблемы в дополнение к значениям этих параметров). Они также отличаются высокой дисперсией, что означает, что прогнозы варьируются в зависимости от конкретных данных, используемых для их обучения. Эта дополнительная гибкость и мощность достигается за счет необходимости большего количества обучающих данных, часто намного большего объема данных.

Фактически, некоторые нелинейные алгоритмы, такие как методы глубокого обучения, могут продолжать совершенствоваться, если вы дадите им больше данных.

Если линейный алгоритм достигает хорошей производительности с сотнями примеров на класс, вам может понадобиться тысячи примеров на класс для нелинейного алгоритма, такого как случайный лес или искусственная нейронная сеть.

6. Оцените размер набора данных и умение модели

При разработке нового алгоритма машинного обучения часто демонстрируют и даже объясняют производительность алгоритма в зависимости от объема данных или сложности проблемы.

Эти исследования могут или не могут быть выполнены и опубликованы автором алгоритма, и могут или не могут существовать для алгоритмов или типов задач, с которыми вы работаете.

Я бы предложил провести собственное исследование с использованием имеющихся данных и одного хорошо работающего алгоритма, такого как случайный лес.

Составьте исследование, в котором оценивается умение модели в зависимости от размера набора обучающих данных.

Построение результата в виде линейного графика с размером набора обучающих данных на оси X и навыком модели на оси Y даст вам представление о том, как размер данных влияет на навык модели в конкретной задаче.

Этот график называетсякривая обучения,

Из этого графика вы можете спроецировать объем данных, необходимый для разработки умелой модели, или, возможно, сколько данных вам действительно нужно, прежде чем вы достигнете точки перегиба убывающей доходности.

Я настоятельно рекомендую этот подход в целом для разработки надежных моделей в контексте всестороннего понимания проблемы.

7. Наивный догадка

Вам нужно много данных при применении алгоритмов машинного обучения.

Зачастую вам требуется больше данных, чем может потребоваться в классической статистике.

Я часто отвечаю на вопрос о том, сколько данных требуется с легкомысленным ответом:

Получите и используйте как можно больше данных.

Если ответить на вопрос и не знать специфику вашей проблемы, я бы сказал что-то наивное:

Опять же, это просто дополнительные предположения, но это отправная точка, если вам это нужно. Так что начните!

Большие данные часто обсуждаются вместе с машинным обучением, но вам может не потребоваться, чтобы большие данные соответствовали вашей прогностической модели.

Некоторые проблемы требуют больших данных, всех данных, которые у вас есть. Например, простой статистический машинный перевод:

Если вы выполняете традиционное прогнозное моделирование, то, скорее всего, будет наблюдаться уменьшение прибыли в размере обучающего набора, и вам следует изучить свои проблемы и выбранные вами модели, чтобы увидеть, где эта точка находится.

Не медлите; Начать

Теперь прекратите готовиться к моделированию вашей проблемы и моделируйте ее.

Не позволяйте проблеме размера обучающего набора помешать вам начать работу над проблемой прогнозирующего моделирования.

Во многих случаях я рассматриваю этот вопрос как причину для промедления.

Получите все данные, которые вы можете, используйте то, что у вас есть, и посмотрите, насколько эффективны модели для вашей проблемы.

Изучите что-то, затем примите меры, чтобы лучше понять, что у вас есть, с помощью дальнейшего анализа, дополнить ваши данные дополнением или собрать больше данных из своего домена.

Дальнейшее чтение

Этот раздел предоставляет больше ресурсов по этой теме, если вы хотите углубиться.

Этот вопрос широко обсуждается на таких сайтах Q & A, как Quora, StackOverflow и CrossValidated. Ниже приведено несколько примеров выбора, которые могут помочь.

Я ожидаю, что есть некоторые большие статистические исследования по этому вопросу; вот несколько я мог найти.

Другие связанные статьи.

Если вы знаете больше, пожалуйста, дайте мне знать в комментариях ниже.

Резюме

В этом посте вы обнаружили набор способов думать и рассуждать о проблеме ответа на общий вопрос:

Сколько данных обучения мне нужно для машинного обучения?

Помог ли какой-либо из этих методов?

Позвольте мне знать в комментариях ниже.

У вас есть вопросы?

Задайте свои вопросы в комментариях ниже, и я сделаю все возможное, чтобы ответить.

За исключением, конечно, вопроса о том, сколько данныхвыконкретно нужно.