Запретить поисковикам индексировать эту страницу что это значит

Какие страницы следует закрывать от индексации

Индексирование сайта – это процесс, с помощью которого поисковые системы, подобные Google и Yandex, анализируют страницы веб-ресурса и вносят их в свою базу данных. Индексация выполняется специальным ботом, который заносит всю необходимую информацию о сайте в систему – веб-страницы, картинки, видеофайлы, текстовый контент и прочее. Корректное индексирование сайта помогает потенциальным клиентам легко найти нужный сайт в поисковой выдаче, поэтому важно знать обо всех тонкостях данного процесса.

В сегодняшней статье я рассмотрю, как правильно настроить индексацию, какие страницы нужно открывать для роботов, а какие нет.

Почему важно ограничивать индексацию страниц

Заинтересованность в индексации есть не только у собственника веб-ресурса, но и у поисковой системы – ей необходимо предоставить релевантную и, главное, ценную информацию для пользователя. Чтобы удовлетворить обе стороны, требуется проиндексировать только те страницы, которые будут интересны и целевой аудитории, и поисковику.

Прежде чем переходить к списку ненужных страниц для индексации, давайте рассмотрим причины, из-за которых стоит запрещать их выдачу. Вот некоторые из них:

В краулинговый бюджет входят: взломанные страницы, файлы CSS и JS, дубли, цепочки редиректов, страницы со спамом и прочее.

Что нужно скрывать от поисковиков

В первую очередь стоит ограничить индексирование всего сайта, который еще находится на стадии разработки. Именно так можно уберечь базу данных поисковых систем от некорректной информации. Если ваш веб-ресурс давно функционирует, но вы не знаете, какой контент стоит исключить из поисковой выдачи, то рекомендуем ознакомиться с нижеуказанными инструкциями.

PDF и прочие документы

Часто на сайтах выкладываются различные документы, относящиеся к контенту определенной страницы (такие файлы могут содержать и важную информацию, например, политику конфиденциальности).

Рекомендуется отслеживать поисковую выдачу: если заголовки PDF-файлов отображаются выше в рейтинге, чем страницы со схожим запросом, то их лучше скрыть, чтобы открыть доступ к наиболее релевантной информации. Отключить индексацию PDF и других документов вы можете в файле robots.txt.

Разрабатываемые страницы

Стоит всегда избегать индексации разрабатываемых страниц, чтобы рейтинг сайта не снизился. Используйте только те страницы, которые оптимизированы и наполнены уникальным контентом. Настроить их отображение можно в файле robots.txt.

Копии сайта

Если вам потребовалось создать копию веб-ресурса, то в этом случае также необходимо все правильно настроить. В первую очередь укажите корректное зеркало с помощью 301 редиректа. Это позволит оставить прежний рейтинг у исходного сайта: поисковая система будет понимать, где оригинал, а где копия. Если же вы решитесь использовать копию как оригинал, то делать это не рекомендуется, так как возраст сайта будет обнулен, а вместе с ним и вся репутация.

Веб-страницы для печати

Иногда контент сайта требует уникальных функций, которые могут быть полезны для клиентов. Одной из таких является «Печать», позволяющая распечатать необходимые страницы на принтере. Создание такой версии страницы выполняется через дублирование, поэтому поисковые роботы могут с легкостью установить копию как приоритетную. Чтобы правильно оптимизировать такой контент, необходимо отключить индексацию веб-страниц для печати. Сделать это можно с использованием AJAX, метатегом либо в файле robots.txt.

Формы и прочие элементы сайта

Большинство сайтов сейчас невозможно представить без таких элементов, как личный кабинет, корзина пользователя, форма обратной связи или регистрации. Несомненно, это важная часть структуры веб-ресурса, но в то же время она совсем бесполезна для поисковых запросов. Подобные типы страниц необходимо скрывать от любых поисковиков.

Страницы служебного пользования

Формы авторизации в панель управления и другие страницы, используемые администратором сайта, не несут никакой важной информации для обычного пользователя. Поэтому все служебные страницы следует исключить из индексации.

Личные данные пользователя

Вся персональная информация должна быть надежно защищена – позаботиться о ее исключении из поисковой выдачи нужно незамедлительно. Это относится к данным о платежах, контактам и прочей информации, идентифицирующей конкретного пользователя.

Страницы с результатами поиска по сайту

Как и в случае со страницами, содержащими личные данные пользователей, индексация такого контента не нужна: веб-страницы результатов полезны для клиента, но не для поисковых систем, так как содержат неуникальное содержание.

Сортировочные страницы

Контент на таких веб-страницах обычно дублируется, хоть и частично. Однако индексация таких страниц посчитается поисковыми системами как дублирование. Чтобы снизить риск возникновения таких проблем, рекомендуется отказаться от подобного контента в поисковой выдаче.

Пагинация на сайте

Пагинация – без нее сложно представить существование любого крупного веб-сайта. Чтобы понять ее назначение, приведу небольшой пример: до появления типичных книг использовались свитки, на которых прописывался текст. Прочитать его можно было путем развертывания (что не очень удобно). На таком длинном холсте сложно найти нужную информацию, нежели в обычной книге. Без использования пагинации отыскать подходящий раздел или товар также проблематично.

Пагинация позволяет разделить большой массив данных на отдельные страницы для удобства использования. Отключать индексирование для такого типа контента нежелательно, требуется только настроить атрибуты rel=”canonical”, rel=”prev” и rel=”next”. Для Google нужно указать, какие параметры разбивают страницы – сделать это можно в Google Search Console в разделе «Параметры URL».

Помимо всего вышесказанного, рекомендуется закрывать такие типы страниц, как лендинги для контекстной рекламы, страницы с результатами поиска по сайту и поиск по сайту в целом, страницы с UTM-метками.

Какие страницы нужно индексировать

Ограничение страниц для поисковых систем зачастую становится проблемой – владельцы сайтов начинают с этим затягивать или случайно перекрывают важный контент. Чтобы избежать таких ошибок, рекомендуем ознакомиться с нижеуказанным списком страниц, которые нужно оставлять во время настройки индексации сайта.

Соблюдение индексации таких страниц может значительно улучшить поисковую выдачу, если ранее оптимизация не проводилась.

Как закрыть страницы от индексации

Мы детально рассмотрели список всех страниц, которые следует закрывать от поисковых роботов, но о том, как это сделать, прошлись лишь вскользь – давайте это исправлять. Выполнить это можно несколькими способами: с помощью файла robots.txt, добавления специальных метатегов, кода, сервисов для вебмастеров, а также с использованием дополнительных плагинов. Рассмотрим каждый метод более детально.

Способ 1: Файл robots.txt

Данный текстовый документ – это файл, который первым делом посещают поисковики. Он предоставляет им информацию о том, какие страницы и файлы на сайте можно обрабатывать, а какие нет. Его основная функция – сократить количество запросов к сайту и снизить на него нагрузку. Он должен удовлетворять следующим критериям:

Прежде чем переходить к редактированию файла, рекомендую обратить внимание на ограничивающие факторы.

Файл robots.txt включает в себя такие параметры, как:

Теперь давайте рассмотрим, как можно отключить индексацию определенных страниц или всего сайта. Все пути в примерах – условные.

Пропишите, чтобы исключить индексацию сайта для всех роботов:

Что такое индексация сайта

11 декабря 2017 Опубликовано в разделах: Азбука терминов. 31611

Индексация сайта значит, что робот поисковой системы посещает ресурс и его страницы, изучает контент и заносит его в базу данных.Впоследствии эта информация выдается по ключевым запросам. То есть, пользователи сети вводят в строку поиска запрос и получают на него ответ в виде списка проиндексированных страниц.

Если говорить простым языком, получится приблизительно так: весь интернет — это огромная библиотека. В любой уважающей себя библиотеке есть каталог, который облегчает поиск нужной информации. В середине 90-х годов прошлого века, вся индексация сводилась к такой каталогизации. Роботы находили на сайтах ключевые слова и формировали из них базу данных.

Сегодня боты собирают и анализируют информацию по нескольким параметрам (ошибки, уникальность, полезность, доступность и проч.) прежде, чем внести ее в индекс поисковой системы.

Алгоритмы работы поисковых роботов постоянно обновляются и становятся все сложнее. Базы данных содержат огромное количество информации, несмотря на это поиск нужных сведений не занимает много времени. Это и есть пример качественной индексации.

Если сайт не прошел индексацию, то информация до пользователей может и не дойти.

Как индексирует сайты Гугл и Яндекс

Яндекс и Гугл, пожалуй, самые популярные поисковики в России. Чтобы поисковые системы проиндексировали сайт, о нем нужно сообщить. Сделать это можно двумя способами:

Второй способ медленнее, сайт встает в очередь и индексируется в течение двух недель или больше.

В среднем, новые сайты и страницы проходят индексацию за 1–2 недели.

Считается, что Гугл индексирует сайты быстрее. Это происходит потому, что поисковая система Google индексирует все страницы — и полезные, и неполезные. Однако в ранжирование попадает только качественный контент.

Яндекс работает медленнее, но индексирует полезные материалы и сразу исключает из поиска все мусорные страницы.

Индексирование сайта происходит так:

Есть 3 способа проверки индексации сайта и его страниц в Гугл и Яндексе:

Проверяем индексацию

Это можно сделать используя:

Как ускорить индексацию сайта

От того, насколько быстро роботы проведут индексирование, зависит скорость появления нового материала в поисковой выдаче, тем быстрее на сайт придет целевая аудитория.

Для ускорения индексации поисковыми системами нужно соблюсти несколько рекомендаций.

Как закрыть сайт от индексации

Закрыть сайт от индексации — запретить поисковым роботам доступ к сайту, к некоторым его страницам, части текста или изображению. Обычно это делается для того, чтобы скрыть от публичного доступа секретную информацию, технические страницы, сайты на уровне разработки, дублированные страницы и т. п.

Сделать это можно несколькими способами:

User-agent: *

Disallow: /

Запись для запрета индексации всего документа будет выглядеть так:

Можно создать запрет для конкретного робота:

На что влияет индексация при продвижении

Благодаря индексации сайты попадают в поисковую систему. Чем чаще обновляется контент, тем быстрее это происходит, так как боты чаще приходят на сайт. Это приводит к более высокой позиции при выдаче на запрос.

Индексация сайта в поисковых системах дает приток посетителей и способствует развитию проекта.

Кроме контента, роботы оценивают посещаемость и поведение посетителей. На основании этих факторов они делают выводы о полезности ресурса, чаще посещают сайт, что поднимает на более высокую позицию в поисковой выдаче. Следовательно, трафик снова увеличивается.

Индексация — это важный процесс для продвижения проектов. Чтобы индексирование прошло успешно, поисковые роботы должны убедиться в полезности информации.

Алгоритмы, по которым работают поисковые машины, постоянно меняются и усложняются. Цель индексации — внесение информации в базу данных поисковых систем.

Запретить поисковикам индексировать эту страницу что это значит

Владелец сайта может влиять на то, как индексируется его ресурс.

Например, вы можете запросто закрыть для поисковой системы определённые разделы своего сайта. Для этого нужно добавить соответствующие команды в файл robots.txt — он находится в корневой папке сайта. Именно к этому файлу обращаются поисковые роботы, чтобы узнать, что можно индексировать, а что нет.

Поисковые системы исходят из того, что индексировать можно всё, что не запрещено. Поэтому владельцу сайта нужно самому позаботиться о том, чтобы в поиск не попала конфиденциальная информация — например, личные данные пользователей, их переписка или счета. Такие страницы нужно запретить индексировать. Рекомендуем также закрыть страницы со служебной информацией и страницы-дубликаты.

Многие системы управления сайтами (CMS) автоматически создают файл robots.txt и команды для роботов. Яндекс.Вебмастер позволяет проверить файл robots.txt на наличие ошибок. Для этого нужно загрузить содержимое файла в инструмент «Анализатор robots.txt». Для этого можно просто скопировать данные файла и вставить их в форму. Или загрузить файл robots.txt через интерфейс сервиса.

Сервис проверит файл и покажет, есть ли в нём ошибки.

Теперь поговорим о том, как создать правило для робота. Каждое правило состоит из двух элементов: это обращение к роботу и команда.

Если вы хотите обратиться сразу ко всем роботам, используйте элемент «User-agent:*». Для обращения только к роботу Яндекса нужно выбрать элемент «User-agent: Yandex».

Вы можете дать роботу команду «Allow:» (разрешить индексирование) или «Disallow:» (запретить индексирование). После команды нужно указать адрес, для которого должна применяться команда.

Например, так будет выглядеть правило, запрещающее всем поисковым роботам индексировать раздел siteforyandex.ru/admin:

Анализатор помогает найти ошибки в файле robots.txt, проверить, все ли команды прописаны верно и понятны роботу, и узнать, разрешена ли к индексированию конкретная страница.

Файл robots.txt позволяет закрыть для индексирования весь контент страницы. Если вы хотите закрыть только какую-то часть контента, используйте тег noindex. Этот тег не даёт индексировать заключенный в него текст, но не мешает поисковой системе переходить по ссылкам внутри текста.

Совет

Чтобы узнать, какие разделы сайта и в каком объёме уже проиндексированы, воспользуйтесь инструментом «Структура сайта» в Яндекс.Вебмастере, он находится в разделе «Индексирование».

Как закрыть сайт от индексации

Поделиться этим постом

Закрывать сайт от индексации нужно, например, при проведении технических работ. Это можно сделать несколькими способами: через robots.txt, метатег robots или заголовок X-Robots-Tag. Вебмастера иногда сталкиваются с ситуацией, когда запрет не срабатывает, и страницы сайта все равно индексируются поисковиками. В посте расскажем о том, как запретить индексацию сайта и убедиться в корректности этого запрета.

1. Зачем закрывать сайт или страницу от индексации

После релиза сайта его страницы сканируются роботами при первом обходе. Однако если дизайн и контент страниц пока ещё не оптимизированы для продвижения, рекомендуется на время доработок закрыть сайт от поисковиков. В каких ещё ситуациях нужен запрет на индексацию:

Запрет на сканирование — часто временное явление. После окончания технических работ вы сможете вернуть сайт в прежнее состояние. Такой шаг помогает сохранить позиции в выдаче.

2. Как закрыть сайт от индексации

Я уже упомянула, что полностью запретить индексацию сайта можно тремя способами. Теперь предлагаю рассмотреть каждый из них отдельно.

2.1. Robots.txt

Файл robots.txt позволяет запретить индексацию страниц, разделов или всего сайта. Используйте директиву Disallow в качестве команды для поисковых роботов. Если нужно закрыть весь сайт от всех роботов, пропишите в файле robots.txt:

Для обращения к конкретному роботу вместо «*» используйте его название. Например, если нужно закрыть сайт от Яндекс, впишите в robots.txt:

Если требуется закрыть от индексации всеми роботами определённые разделы, укажите их после директивы Disallow. Для каждого типа контента используйте отдельную директиву. Пример:

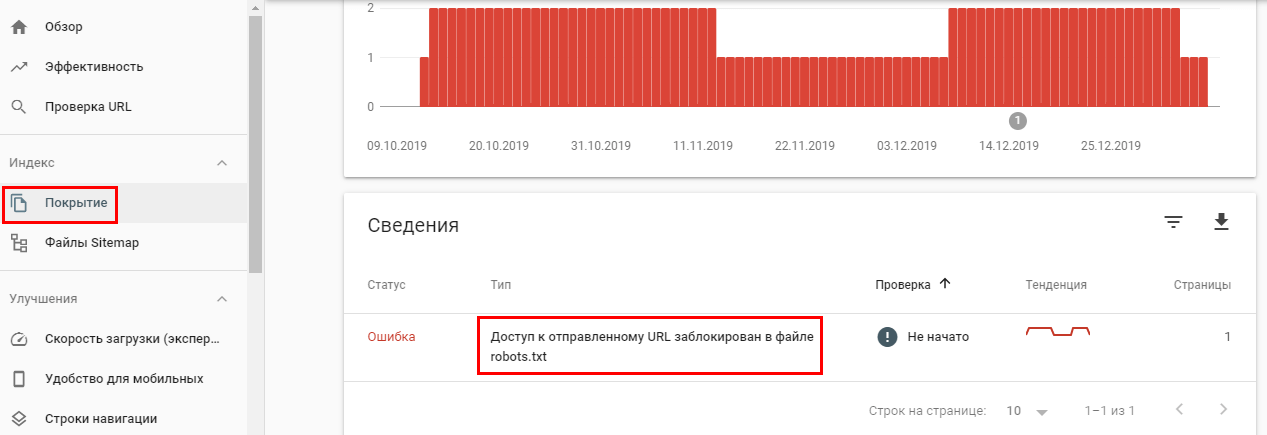

Многие SEO-оптимизаторы отмечают, что Google часто игнорирует директиву Disallow и продолжает индексировать все страницы сайта. Проверить это можно в Google Search Console.

Если страница закрыта от индекса в robots.txt, но это не указано в панели вебмастеров, скорее всего, Google-бот продолжит индексировать эту страницу.

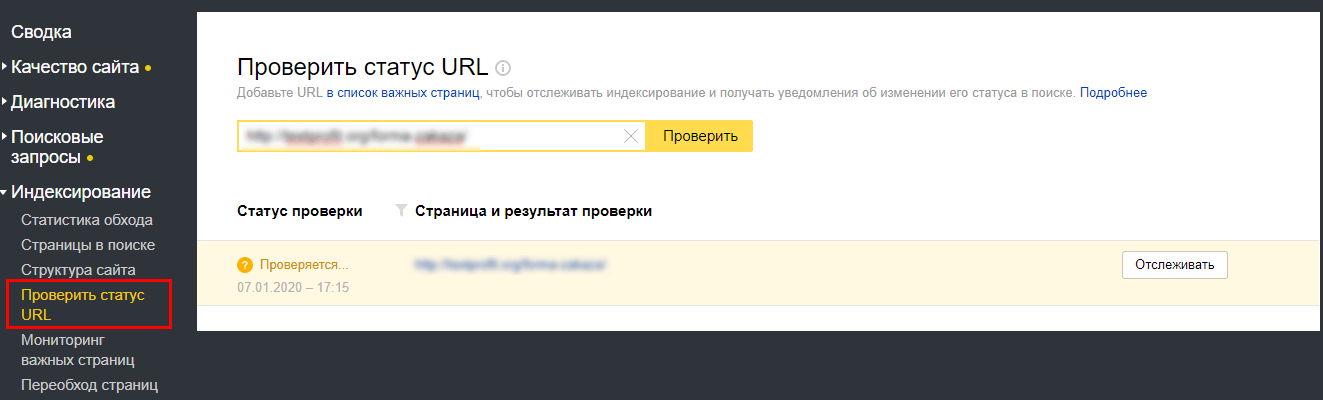

Для проверки в Яндекс.Вебмастер перейдите в раздел «Индексирование».

Если директива Disallow в robots.txt не помогает закрыть страницу от индексации, используйте следующий метод.

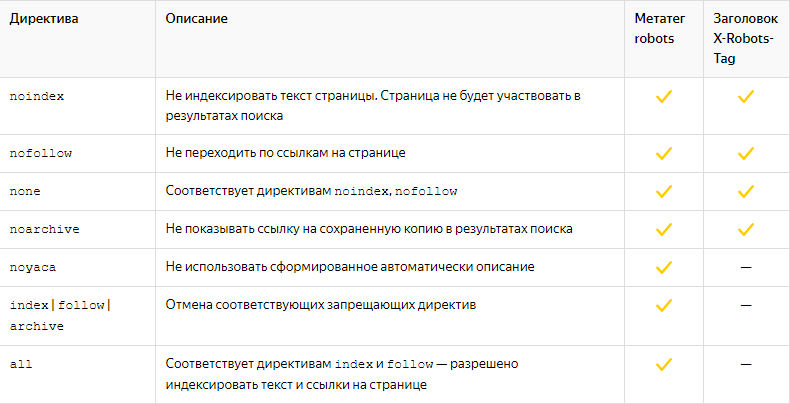

2.2. Метатег Robots

Этим способом можно предотвратить сканирование роботами контента. С его помощью можно также закрыть текст от индексации. Это необходимо, когда страницу нужно проиндексировать за исключением отрывка текста. Для этого добавьте в раздел страницы строку кода:

Чтобы скрыть ссылку от поисковиков, используйте nofollow:

Если и этот вариант не помогает, используйте метод серверного заголовка, описанный в следующем пункте.

2.3. X-Robots-Tag

С помощью X-Robots-Tag можно закрыть от индексации медиа-контент, скрипты и другие файлы. Для этого нужно указать их формат после директивы FilesMatch в первой строке заголовка.

Большинство директив, которые можно использовать в X-Robots-Tag, совпадают с директивами Robots.

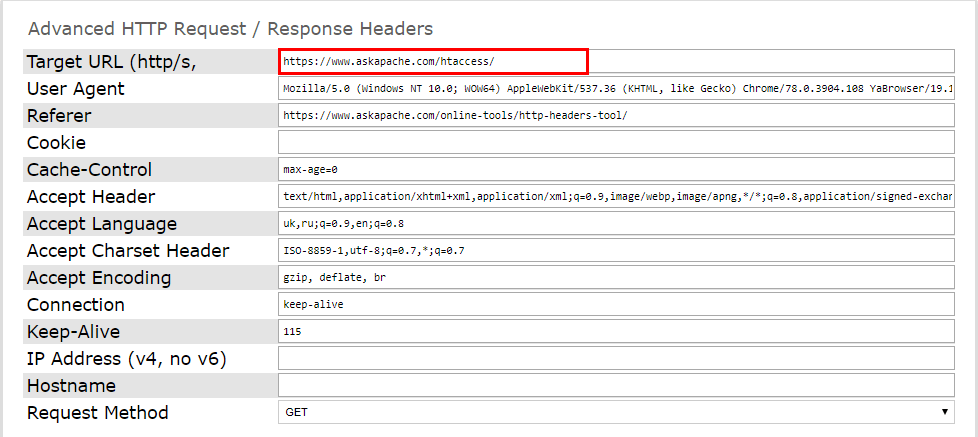

И проверьте работоспособность серверного заголовка. Это можно сделать при помощи онлайн-инструментов. Например, Askapache. Введите нужную страницу и запустите проверку.

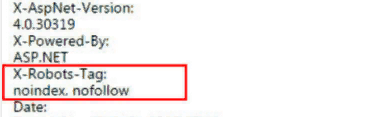

Подключённый заголовок выглядит так:

Проверить код ответа сервера можно и через Яндекс.Вебмастер. Активный X-Robots-Tag отобразится в списке всех заголовков ответа сервера.

Как закрыть сайт от индексации поисковых систем: 5 проверенных способов

Очень часто требуется закрыть сайт от индексации, например при его разработке, чтобы ненужная информация не попала в индекс поисковых систем или по другим причинам. При этом есть множество способов, как это можно сделать, все их мы и рассмотрим в этой статье.

Зачем сайт закрывают для индекса?

Есть несколько причин, которые заставляют вебмастеров скрывать свои проекты от поисковых роботов. Зачастую к такой процедуре они прибегают в двух случаях:

Не думайте, что если ваш ресурс только появился на свет и вы не отправили поисковикам ссылки для его индексации, то они его не заметят. Роботы помимо ссылок учитывают еще и ваши посещения через браузер.

Какие есть способы запрета индексации сайта?

1. Закрытие индексации через WordPress

Если сайт создан на базе WordPress, это ваш вариант. Скрыть проект от ботов таким образом проще и быстрее всего:

Благодаря встроенной функции, движок автоматически изменит robots.txt, откорректировав правила и отключив тем самым индексацию ресурса.

На заметку. Следует отметить, что окончательное решение, включать сайт в индекс или нет, остается за поисковиками, и ниже можно увидеть это предупреждение. Как показывает практика, с Яндексом проблем не возникает, а вот Google может продолжить индексировать документы.

2. Посредством файла robots.txt

Если у вас нет возможности проделать эту операцию в WordPress или у вас стоит другой движок сайта, удалить веб-сайт из поисковиков можно вручную. Это также реализуется несложно. Создайте обычный текстовый документ, разумеется, в формате txt, и назовите его robots.

Затем скиньте его в корневую папку своего портала, чтобы этот файл мог открываться по такому пути site.ru/robots.txt

Но сейчас он у вас пустой, поэтому в нем потребуется прописать соответствующие команды, которые позволят закрыть сайт от индексации полностью или только определенные его элементы. Рассмотрим все варианты, которые вам могут пригодиться.

Закрыть сайта полностью для всех поисковых систем

Укажите в robots.txt команду:

Это позволит запретить ботам всех поисковиков обрабатывать и вносить в базу данных всю информацию, находящуюся на вашем веб-ресурсе. Проверить документ robots.txt, как мы уже говорили, можно, введя в адресной строке браузера: Название__вашего_домена.ru/robots.txt. Если вы все сделали правильно, то увидите все, что указано в файле. Но если, перейдя по указанному адресу, вам выдаст ошибку 404, то, скорее всего, вы скинули файл не туда.

Отдельную папку

Так вы скроете все файлы, находящиеся в указанной папке.

Только в Яндексе

Чтобы перепроверить, получилось ли у вас удалить свой блог из Яндекса, добавьте его в Яндекс.Вебмастер, после чего зайдите в соответствующий раздел по ссылке https://webmaster.yandex.ru/tools/robotstxt/. В поле для проверки URL вставьте несколько ссылок на документы ресурса, и нажмите «Проверить». Если они скрыты от ботов, напротив них в результатах будет написано «Запрещено правилом /*?*».

Только для Google

Проверить, получилось ли сделать запрет, или нет, можно аналогичным способом, что и для Яндекса, только вам нужно будет посетить панель вебмастера Google Search Console. Если документ закрыт от поисковика, то напротив ссылки будет написано «Заблокировано по строке», и вы увидите ту самую строку, которая дала команду ботам не индексировать его.

Но с большой вероятностью вы можете увидеть «Разрешено». Здесь два варианта: либо вы что-то сделали неправильно, либо Google продолжает индексировать запрещенные в документе robots страницы. Я уже упоминал об этом выше, что для поисковых машин данный документ несет лишь рекомендационный характер, и окончательное решение по индексированию остается за ними.

Для других поисковиков

Все поисковики имеют собственных ботов с уникальными именами, чтобы вебмастера могли прописывать их в robots.txt и задавать для них команды. Представляем вашему вниманию самые распространенные (кроме Яндекса и Google):

Список имен всех ботов вы с легкостью найдете в интернете.

Скрыть изображения

Чтобы поисковики не могли индексировать картинки, пропишите такие команды (будут зависеть от формата изображения):

Закрыть поддомен

Любой поддомен содержит собственный robots.txt. Как правило, он находится в корневой для поддомена папке. Откройте документ, и непосредственно там укажите:

Если такого текстового документа в папке поддомена нет, создайте его самостоятельно.

3. С применением тега name=”robots”

4. В настройках сервера

5. С помощью HTTP заголовка X-Robots-Tag

Мы подробно расписали как этот способ настроить и использовать в нашей статье.

Как проверить индексацию сайта и страниц?

Заключение

Вне зависимости от того, по какой причине вы хотите закрыть сайт, отдельные его страницы или материалы от индексации, можете воспользоваться любым из перечисленных способов. Они простые в реализации, и на их настройку не потребуется много времени. Вы самостоятельно сможете скрыть нужную информацию от роботов, однако стоит учесть, что не все методы помогут на 100%.