Обнаружен тег noindex в метатеге robots как исправить

Полное руководство по Robots.txt и метатегу Noindex

Файл Robots.txt и мета-тег Noindex важны для SEO-продвижения. Они информируют Google, какие именно страницы необходимо сканировать, а какие – индексировать (отображать в результатах поиска).

С помощью этих средств можно ограничить содержимое сайта, доступное для индексации.

Что такое файл Robots.txt?

Robots.txt – это файл, который указывает поисковым роботам (например, Googlebot и Bingbot), какие страницы сайта не должны сканироваться.

Чем полезен файл Robots.txt?

Файл robots.txt сообщает роботам системам, какие страницы могут быть просканированы. Но не может контролировать их поведение и скорость сканирования сайта. Этот файл, по сути, представляет собой набор инструкций для поисковых роботов о том, к каким частям сайта доступ ограничен.

Как создать файл Robots.txt?

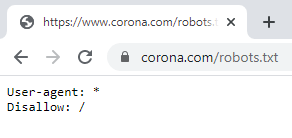

По умолчанию файл robots.txt выглядит следующим образом:

Директивы для сканирования поисковыми системами

User-Agent: определяет поискового робота, для которого будут применяться ограничения в сканировании URL-адресов. Например, Googlebot, Bingbot, Ask, Yahoo.

Disallow: определяет адреса страниц, которые запрещены для сканирования.

Allow: только Googlebot придерживается этой директивы. Она разрешает анализировать страницу, несмотря на то, что сканирование родительской веб-страницы запрещено.

Sitemap: указывает путь к файлу sitemap сайта.

Правильное использование универсальных символов

В файле robots.txt символ (*) используется для обозначения любой последовательности символов.

Директива для всех типов поисковых роботов:

Также символ * можно использовать, чтобы запретить все URL-адреса кроме родительской страницы.

Это означает, что все URL-адреса дочерних страниц авторов и страниц категорий заблокированы за исключением главных страниц этих разделов.

Ниже приведен пример правильного файла robots.txt:

Что такое Noindex?

Noindex – это метатег, который запрещает поисковым системам индексировать страницу.

Как применять метатег Noindex?

Существует три способа добавления Noindex на страницы:

Метатег «robots»

Разместите приведенный ниже код в раздел страницы:

Он сообщает всем типам поисковых роботов об условиях индексации страницы. Если нужно запретить индексацию страницы только для определенного робота, поместите его название в значение атрибута name.

Чтобы запретить индексацию страницы для Googlebot:

Чтобы запретить индексацию страницы для Bingbot:

Также можно разрешить или запретить роботам переход по ссылкам, размещенным на странице.

Чтобы разрешить переход по ссылкам на странице:

Чтобы запретить поисковым роботам сканировать ссылки на странице:

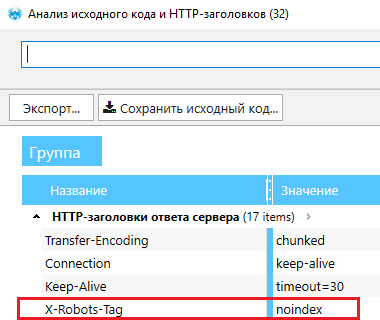

X-Robots-Tag

x-robots-tag позволяет управлять индексацией страницы через HTTP-заголовок. Этот тег также указывает поисковым системам не отображать определенные типы файлов в результатах поиска. Например, изображения и другие медиа-файлы.

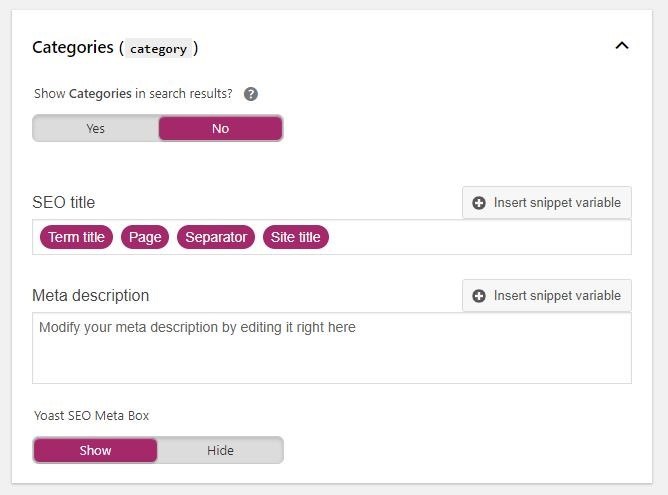

Блокировка индексации через YoastSEO

Плагин YoastSEO в WordPress автоматически генерирует приведенный выше код. Для этого на странице записи перейдите в интерфейсе YoastSEO в настройки публикации, щелкнув по значку шестеренки. Затем в опции «Разрешить поисковым системам показывать эту публикацию в результатах поиска?» выберите «Нет».

Также можно задать тег noindex для страниц категорий. Для этого зайдите в плагин Yoast, в «Вид поиска». Если в разделе «Показать категории в результатах поиска» выбрать «Нет», тег noindex будет размещен на всех страницах категорий.

Лучшие примеры использования

Добавляем Noindex в Robots.txt

В последнее время в SEO-сообществе было много недоразумений по поводу использования noindex в robots.txt. Но представители Google много раз говорили, что поисковая система не поддерживают данный метатег. И все же многие люди настаивают на том, что он все еще работает. Но лучше избегать его использования.

Заблокированная страница все равно может быть проиндексирована, если кто-то на нее ссылается

Заблокированные через robots.txt страницы, не могут быть проиндексированы, даже если кто-то на них ссылается.

Чтобы быть уверенным, что страница без контента случайно не появится в результатах поиска, Джон Мюллер рекомендует размещать на этих веб-страницах noindex даже после того, как вы заблокировали их в robots.txt.

Заключение

Использование файла robots.txt улучшает не только SEO, но и пользовательский опыт. Для этого реализуйте приведенные выше практики.

Пожалуйста, оставьте ваши комментарии по текущей теме статьи. Мы очень благодарим вас за ваши комментарии, отклики, лайки, подписки, дизлайки!

Управляем индексацией с помощью Noindex Nofollow и других примочек

Когда нужно запретить индексацию целой категории или ряда страниц, это легче сделать с помощью правильного robots.txt. Но как быть, если требуется закрыть от индексации одну страницу либо вообще часть текста на странице? Поговорим сейчас об элементах, которые призваны решать именно эту проблему.

Что такое мета тег Robots

Сначала уясним, что есть мета тег Robots, а есть файл Robots.txt, и путать их не будем. Метатег имеет отношение только к одной html странице (на которой он указан), в то время, как файл txt может содержать директивы не только к странице, но к целым каталогам.

При помощи мета тега Robots можно запрещать индексировать содержимое всей страницы. На страницах моего блога он выглядит так:

Это означает, что метатег роботс не запрещает индексировать страницу. Noodp тут означает, что он запрещает Google брать в сниппеты описание для страниц из каталога DMOZ — это одна из стандартных настроек плагина Yoast SEO, которым я пользуюсь.

А вот как выглядит метатег Robots, который запрещает индексацию страницы:

Как прописать

Дедовский способ — вручную прописать для страницы. Способ подходит для сайтов на чистом HTML.

Для сайтов на CMS рекомендую использовать SEO-плагины. Я, например, для WordPress использую плагин Yoast SEO, и там под каждой записью в режиме редактирования есть такая опция:

То есть проставить нужное значение можно парой щелчков.

Как использовать noindex и nofollow в meta robots

Посмотрим на возможные значения атрибута content:

Поговорим чуть больше о noodp

Иногда Гугл может добавлять в сниппет описание из DMOZ. Именно для этого и используется атрибут noodp. Кстати, его можно использовать вместе с тегом nofollow. Выглядит это так:

Чего нужно опасаться при использовании

Из-за невнимательности (особенно у новичков) могут случаться конфликты между тегами: в таком случае главным будет положительное значение (разрешающее индексацию). Например тут:

Тут выбрано будет первое значение, так как там оно положительно.

Что такое тег Noindex

Noindex — это тег, в который вы заключаете часть кода, и этот код по идее не должен индексироваться Яндексом. Тег ноиндекс был предложен именно Яндексом, и по сей день учитывается только системами Yandex и Rambler. Вот как он выглядит:

Noindex не чувствителен к вложенности.

Целесообразность использования тега

Лично я смысла в его использовании не вижу. Потому что Google этот тег игнорирует. Да и зачем скрывать что-то? Надо делать сайты для людей!

Если же вы все-таки решили пользоваться этим тегом, то гляньте видео от ТопЭксперт:

Как пользоваться тегом Noindex

Нужно просто обернуть им тег:

Валидный Noindex

Чтобы сделать его валидным, нужно закомментировать тег. Выглядит это так:

Для чего нужны теги, запрещающие индексацию

Как я писал выше, тег Noindex вообще ни для чего не нужен. Он себя давно изжил. А вот метатег роботс — довольно нужная вещь. Вот примеры ситуаций, когда он бывает полезен:

Для чего нужен атрибут rel nofollow

Если метатег robots должен закрывать от индексации страницу, а тег noindex — её часть, то атрибут rel nofollow должен запрещать поисковику переходить по ссылке. Он является атрибутом тега А и выглядит так:

На самом деле поисковик вполне себе переходит по ссылкам с этим атрибутом и они вполне себе забирают ссылочный вес у ваших страниц. То есть смысла в этом атрибуте, как и в noindex, нет. Ссылки закрывать эффективно только через Ajax, да и это я думаю не навсегда. Но, если же вы все-таки решили сконцентрировать внимание на этой точке, которая в лучшем случае даст вам микроскопический рост, то вот еще один видос от ТопЭксперт:

Блокировка индексирования при помощи директивы noindex

Вы можете заблокировать показ страницы в Google Поиске, добавив метатег noindex в HTML-код страницы или настроив возврат заголовка noindex в HTTP-ответе. Обнаружив такой метатег или заголовок во время сканирования страницы, робот Googlebot проигнорирует ее, даже если на нее ссылаются другие сайты.

Директива noindex позволяет управлять доступом к отдельным страницам сайта. Это может быть полезно, если у вас нет доступа к корневому каталогу на сервере.

Как применять директиву noindex

Применить директиву noindex можно двумя способами: как метатег или как заголовок HTTP-ответа. Они работают одинаково, поэтому выбор подходящего способа будет зависеть от вашего сайта.

” l10n-translatable-tag-attribute-2-data-text=” tag”>Тег

Чтобы запретить большинству поисковых роботов индексировать определенную страницу вашего сайта, добавьте в ее раздел следующий метатег:

Если вы хотите закрыть доступ к странице только роботам Google, используйте такой код:

Учитывайте, что некоторые поисковые системы могут иначе интерпретировать директиву noindex и показывать в результатах поиска страницу, на которой она используется.

Заголовок HTTP-ответа

Как помочь роботам Googlebot обнаруживать метатеги

Чтобы обнаружить метатеги и HTTP-заголовки, мы должны просканировать вашу страницу. Если страница продолжает появляться в результатах поиска, вероятно, мы ещё не просканировали ее после добавления тега. Воспользуйтесь инструментом проверки URL, чтобы запросить повторное сканирование страницы роботом Google. Другая возможная причина: файл robots.txt запрещает роботу Googlebot доступ к URL и не дает ему обнаружить метатег. Чтобы предоставить роботам Google доступ к вашей странице, вам необходимо изменить файл robots.txt. Это можно сделать с помощью специального инструмента.

Except as otherwise noted, the content of this page is licensed under the Creative Commons Attribution 4.0 License, and code samples are licensed under the Apache 2.0 License. For details, see the Google Developers Site Policies. Java is a registered trademark of Oracle and/or its affiliates.

Вечные вопросы о мета-теге «robots noindex» или что означает «грустная мордочка»

Когда автор обнаруживает этот мета-тег у себя на канале, то начинает беспокоиться, рвать на себе волосы, и задавать вопросы, на которые я попытаюсь ответить.

Каждый раз мне приходится писать одно и то же, и наконец-то я решил, что надо написать одну большую и подробную статью, чтобы просто ссылаться на неё.

Если вам не терпится прочитать, как связаны мета-теги с ограничениями каналов можно перейти сразу сюда.

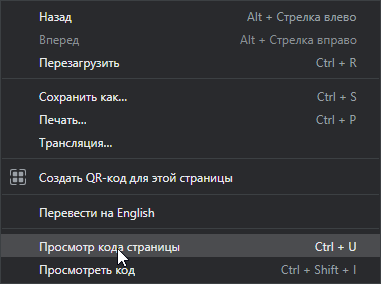

Как выглядит мета-тег и где его посмотреть

Чтобы посмотреть, есть ли мета-тег на обычной странице, нужно кликнуть правой кнопкой мыши в любом месте страницы, и в меню выбрать пункт «Просмотр кода страницы».

Откроется окно с исходным кодом страницы, где среди множества понятных и не очень строчек можно найти нужные нам мета-теги.

Мета-тега на странице может и не быть или он может быть немного другим, и это может менять его значение.

Что означают мета-теги «robots»

Этот мета-тег является командой поисковому роботу (это программа поисковых систем, которая собирает информацию о страницах на различных сайтах). Обнаружив этот мета-тег, поисковый робот понимает, что эта страница не предназначена для включения её в поисковую базу данных и пропускает страницу.

В итоге страница не попадает в поисковую базу (или если она там уже есть — исключается), после чего поисковик не будет включать эту страницу в результаты поиска.

В Дзене этот мета-тег может встречаться на страницах конкретных публикаций (статьи, галереи, видео). И означает лишь то, что по каким-то причинам Дзен решил, что эту статью не должны находить в поиске.

Если этого мета-тега нет, это значит публикация не исключена из поисковой индексации, значит на неё могут (теоретически) приходить читатели, которые ищут статьи в Яндексе или Google.

Почему мета-теги называют «мордочками» или «рожицами»

Это связано с браузерным расширением «ПРОДЗЕН». В нём на страницах публикаций отображается пиктограмма «грустный робот», которую в итоге стали называть «красной мордой», «грустной мордочкой» и т.д.

Как с помощью расширения обнаружить статьи с мета-тегом?

Значок грустного робота на странице канала

При установленном расширении проверка главной страницы канала производится автоматически. Если канал отмечен как неиндексируемый, то в меню расширения пункт «Неиндексируемые» заменяется значением «Канал не индексируется».

Ещё раз подчеркну, что наличие этого кода, а значит и соответствующего оповещения в меню — норма для новых каналов.

Значок «грустного робота» на странице публикации

При установленном расширении на странице публикации может отображаться значок грустного робота.

Соответственно, для того чтобы его увидеть нужно зайти на страницу публикации. Но зато не нужно изучать исходный код страницы.

Поиск публикаций с мета-тегом

Если вы решите проверить не одну, а десяток публикаций, то придётся заходить в каждую и проверять наличие мета-тега в каждой из них. Вручную это неудобно, поэтому в расширении предусмотрена возможность автоматической проверки.

Правда, этот пункт меню будет недоступен, если весь канал отмечен, как неиндексируемый — нет смысла запускать проверку, теги будут обнаружены на всех публикациях.

При первом запуске будет отображено большое страшное предупреждение о том, что процедура поиска производится на страх и риск пользователя.

Дело в том, что стандартной процедуры поиска публикаций с мета-тегом в Дзене не предусмотрено, и расширению приходится буквально открывать каждую проверяемую публикацию и заглядывать в код страницы.

Теоретически это может быть воспринято как DDOS-атака или как попытка накрутить просмотры. На практике с этим проблем не было, но предупредить я вас обязан.

Процедура поиска может занять продолжительное время, по завершении вы получите список публикаций, на которых обнаружен мета-тег.

На мой странице (не) обнаружен мета-тег, а страница (не) видна в поиске

Действительно, так бывает, что статью из Дзена не удаётся найти в поиске, хотя на ней нет зловредного мета-тега; или наоборот — тег есть, но и на статью есть переходы из поиска.

Всё дело в том, что поисковики работают с определённой задержкой, кроме того у них свои алгоритмы, определяющие, отвечает ли статья на поисковый запрос и насколько она релевантна ему.

Статья, которая отлично чувствуют себя в Дзене, собирает сотни тысяч и миллионы показов, поисковику может показаться неинтересной, и тогда он не будет показывать ссылку на неё на первых страницах поиска.

Кроме того, индексирование может занимать продолжительное время, это значит, что после появления (или удаления мета-тега), должно пройти какое-то время, прежде чем изменение будет учтено поисковыми системами.

Как мета-теги связаны с ограничениями канала или публикации

Официально связь мета-тега с ограничениями публикаций не подтверждается. Если написать в техническую поддержку, то вам скорее всего посоветуют не обращать на него внимание.

Тем не менее, наличие мета-тега может говорить о следующих ситуациях:

Важно. Публикация может быть ограничена, но при этом на ней будет установлен мета-тег.

Т.е. отсутствие мета-тега не говорит о том, что с публикацией всё в порядке. А вот наличие мета-тега говорит о том, что с публикацией что-то не так.

Специалисты поддержки часто на обращение с вопросом о мета-тегах могут говорить, что на мета-тег не нужно обращать внимания, а с публикацией всё хорошо (а то что показов всего лишь 9 штук, так это просто статья никому не интересна).

При этом, мне неизвестны такие случаи, чтобы статья с мета-тегом успешно транслировалась в ленту и получала показы.

Что делать если вы обнаружили на статье мета-тег

Ещё раз подчеркну, что наличие мета-тега — норма на новых, не прошедших модерацию каналов. Проверка (или, как говорят, «выход на алл») может занять какое-то время. Иногда каналы успевают достигнуть порога монетизации, в этом случае монетизация не будет подключена до прохождения проверки.

Если канал не новый, то возможны разные ситуации:

Как общаться с технической поддержкой о мета-тегах

Чтобы не тратить зря время, не упоминайте расширение ПРОДЗЕН и термины «красная рожица», «грустная мордочка», «значок робота» и т.п.

Сотрудники ТП не могут комментировать то, как работает расширение, не знают и не должны знать, что оно показывает и т.п. Поэтому упомянув расширение, вы гарантированно получите отказ его обсуждать, иногда даже с советом его не использовать.

Не ссылайтесь только лишь на наличие самого мета-тега.

Если статья новая и не получает показов — так и напишите.

Если публикация опубликована больше суток назад, успешно набирала просмотры, а потом внезапно получила мета-тег, посмотрите график конкретной статьи в метрике — там будет видно, что в какой-то момент резко прекратились просмотры. Приведите скриншот этого графика.

Т.е. основным в вашем письме должно быть то, что возникли проблемы с публикацией. Про мета-тег можно вообще не упоминать, или упоминать в качестве дополнения.

К сожалению, это может не помочь. Если менеджеры, помогающие участникам программы Нирвана, ещё готовы разбираться с проблемами, то сотрудники обычной поддержки очень часто начинают писать стандартные отписки, не сильно вникая в их смысл.

Иногда можно подождать, пока ваше обращение будет отмечено как завершённое и написать ещё раз — если повезёт, вам ответит сотрудник, настроенный как-то помочь вам.

Так же можно обратиться за помощью в официальные группы Дзена в ВК или в телеграме.

Если ничего добиться не удастся, то остаётся только грустить вместе с грустным роботом.

Нужно ли удалять публикации, отмеченные мета-тегом с канала

Итак, вы обнаружили мет-тег, но обращение в техподдержку не помогло.

Давайте рассуждать логически:

Т.е. фактически статья не существует. Удалять её или нет — это ваше личное решение.

Но если у вас есть свой сайт или блог на другой платформе, то я бы рекомендовал перенести статью туда. И удалить. Зачем ей бессмысленно болтаться там, где ей не рады.

Если какой-то трафик на статье есть (а, вдруг?!), то имеет смысла подождать пока ей не исполнится три месяца и тогда удалить.

Почему не индексируется сайт в Google и Яндексе

В прошлой статье «Как добавить сайт в поисковые системы» мы рассказали, как сообщить поисковым роботам о новом сайте или страницах. Но после добавления сайта в поисковые системы, он все еще может не индексироваться в Google или Яндексе. Что еще хуже, поисковые роботы сканировали сайт раньше, но теперь сайт не индексируется. Единственный выход в этой ситуации ― проверить возможные причины, которые влияют на индексацию сайта. Об этих причинах расскажем в статье.

Из статьи вы узнаете:

Сайт закрыт от индексации в Robots.txt

Одна из самых распространенных причин, из-за которой сайт не индексируется ― запрет на индексацию в файле robots.txt. Часто разработчики сайта хранят тестовую версию на отдельных доменах или поддоменах. Тестовый сайт закрывают от индексации с помощью robots.txt. Когда сайт уже готов, содержимое тестовой версии вместе с файлом robots.txt попадает на рабочий домен. Файл robots.txt забывают изменить и сайт становится недоступным для поисковых роботов.

Файл robots.txt находится в корневой папке сайта – https://mysupersite.com/robots.txt

Если сайт закрыт от индексации, содержимое файла может выглядеть следующим образом:

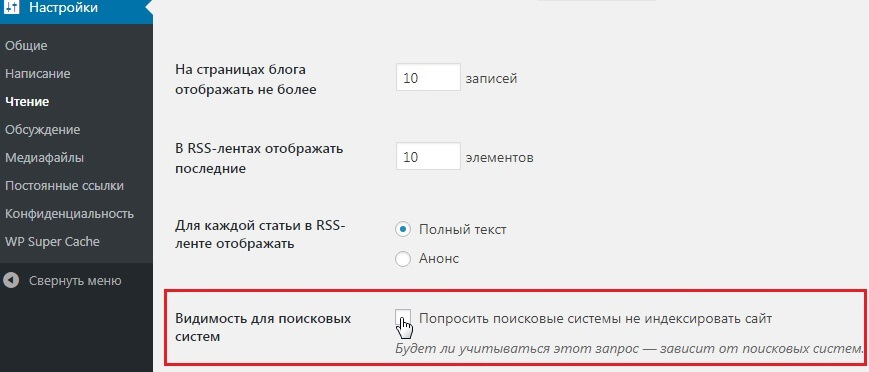

Если у вас сайт на CMS WordPress, проверьте настройки индексации в панели управления сайтом. Зайдите в раздел Настройки → Чтение. Поле Видимость для поисковых систем должно быть пустым:

Как проверить Robots.txt

При помощи следующих инструментов можно проверить не закрыт ли через robots.txt от индексации сайт или определенные страницы:

Предварительно нужно добавить сайт в панель вебмастеров Google или Яндекс, чтобы проверить robots.

Для проверки также можно воспользоваться сторонними сервисами, например https://technicalseo.com/tools/robots-txt/

Если еще не пользуетесь данными сервисами, читайте статью: Как добавить сайт в инструменты веб-мастеров

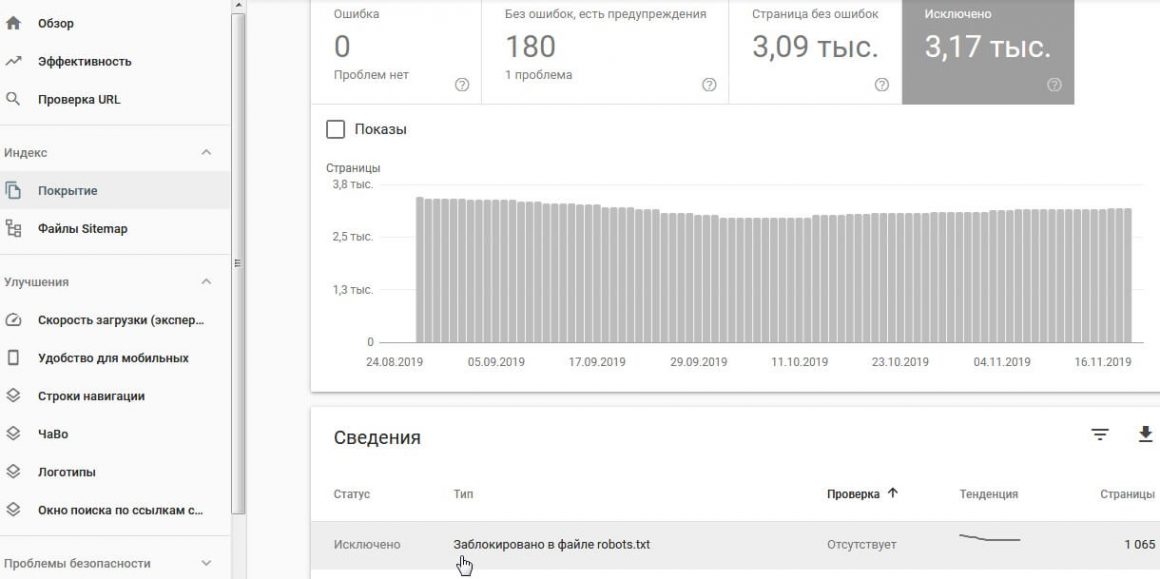

Google Search Console

Отчет Индекс → Покрытие → вкладка Исключено

Яндекс вебмастер

Отчет Диагностика → Диагностика сайта показывает наличие проблем с индексацией сайта.

После сканирования сайта или определенных страниц, в результатах отчета будут показаны страницы, которые недоступны для индексации:

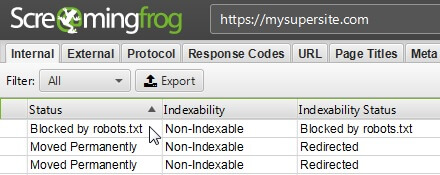

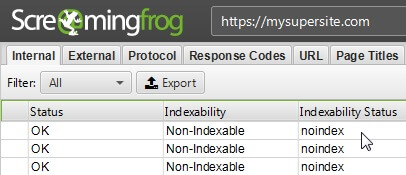

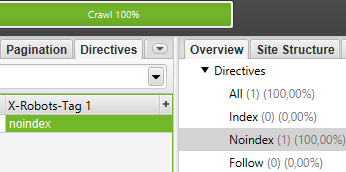

Screaming Frog SEO Spider

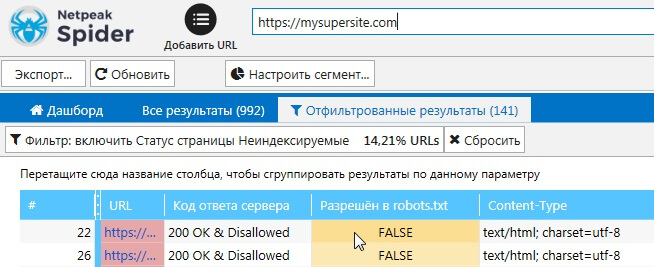

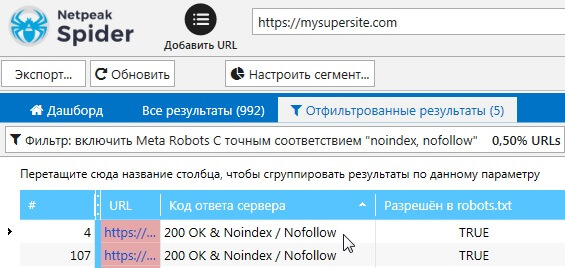

Netpeak Spider

Метатеги Robots

Метатег robots сообщает поисковым роботам о том, что страницу индексировать не нужно.

Как проверить метатеги Robots

Google Search Console

Отчет Индекс → Покрытие → вкладка Исключено

Обнаружить страницы, которые закрыты от индексации с помощью метатегов robots, можно с помощью программ для аудита внутренней оптимизации сайта.

Screaming Frog SEO Spider

Netpeak Spider

Или можно разрешить доступ всем, кроме нужного IP:

Более подробно узнать о директивах и правилах можно в нашей статье: Файл htaccess.

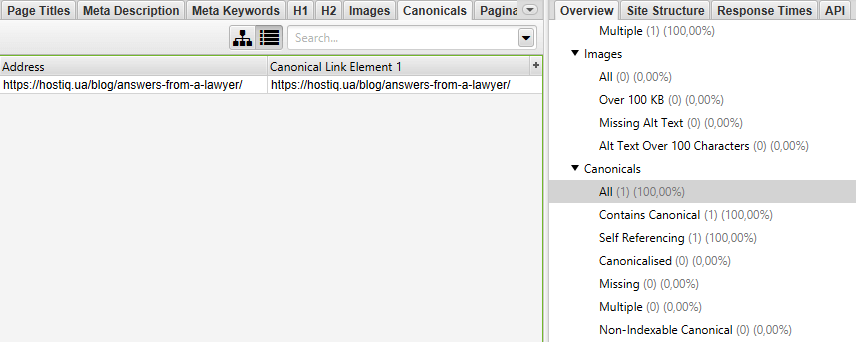

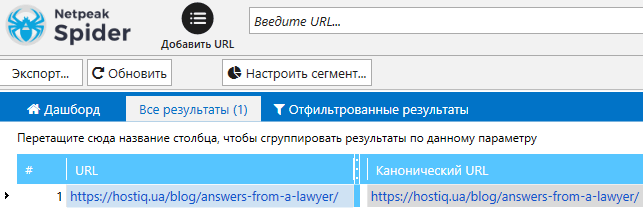

Rel Canonical

Тег rel=”canonical” применяют на страницах с одинаковым содержимым. Этот тег указывает поисковым роботам адрес страницы, которая является основной.

Рассмотрим на примере две страницы, которые имеют одинаковое содержание:

Чтобы в индексе была основная страница, можно применить тег rel=”canonical”. В html код страницы https://mysupersite.com/dublicat-page/ между тегами нужно добавить следующий тег:

Если ваша страница или страницы не индексируются, проверьте наличие тега rel=”canonical” в html коде и его корректность.

Как проверить наличие тегов rel=”canonical”

X‑Robots-Tag

X‑Robots-Tag ― это директива в заголовках ответа сервера, с помощью которой можно запретить роботам индексировать конкретные страницы или файлы. Пример HTTP-ответа сервера с директивой X‑Robots-Tag, которая запрещает индексацию страницы:

Фрагмент кода в файле conf для сервера Nginx

Дополнительную информацию о данном HTTP-заголовке можно получить в справке Google.

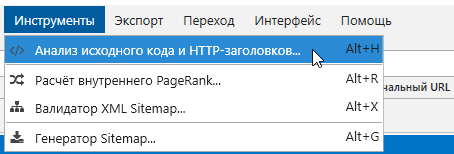

Как проверить наличие X‑Robots-Tag на страницах сайта

Плагин Web Developer для браузеров:

Сервисы или программы для аудита сайта – Screaming Frog, Netpeak Spider и другие аналоги:

Долгий ответ сервера

Время ответа сервера ― это время, за которое запрос клиента в браузере доходит до сервера и клиент получает ответ сервера. Время отклика измеряется в TTFB (Time To First Byte) ― время до первого байта, или сколько миллисекунд прошло между вашим запросом и ответом сервера. Google рекомендует стремиться к тому, чтобы время отклика было менее 200 миллисекунд. TTFB больше 500 мс уже является проблемой.

Если при обращении поискового робота к серверу, он получает долгий ответ, то робот может не просканировать часть страниц..

Как проверить время ответа сервера

Проверить время ответа сервера можно с помощью сервисов:

Возможные причины долгого ответа сервера

Среди возможных причин можно выделить следующие:

Полезные статьи по теме:

Возьмите хостинг на тест и проверьте сами. 30 дней бесплатно!

Пробуйте надежный хостинг с аптаймом 99,5%!

Наша теплая поддержка на связи 24/7

Неверный ответ сервера

Проверьте код ответа сервера. Убедитесь, что нужные вам страницы отдают код 200.

Этот код означает, что страница доступна на сервере.

Как проверить ответ сервера

Проверить ответ сервера можно с помощью инструментов:

Также можно использовать различные плагины для браузеров или можно проверить в самом браузере ― F12+вкладка Network.

Некачественный контент

Если ваши страницы содержат контент, который не имеет ценности для пользователя, то поисковые роботы могут не индексировать их. В англоязычных статьях можно встретить термин thin content, который описывает данные страницы.

Примером такого контента может быть:

Проблемы на стороне поисковых систем

Как говорится ― и на старуху бывает проруха. На стороне поисковых систем тоже могут возникать проблемы. Например, в начале июля в Google возникли проблемы с индексацией нового контента. Об этом можно прочитать в новостях:

В Google оперативно реагируют и исправляют проблемы.

The indexing issues from yesterday have been resolved. Thank you for your patience.

— Google Search Central (@googlesearchc) June 3, 2020

Итоги

Подытожим причины, из-за которых страницы сайта могут не индексироваться:

Руслан Иванов

Работает в сфере SEO с 2007 года. Занимается продвижением HOSTiQ с 2016. Пишет статьи по SEO.